Il y a souvent dans l’éclosion publique d’une technologie, le sentiment d’une sorte « d’agir » magique.

Il y a 20 ans de cela, naissait Shazam, l’application qui permet de « reconnaître » n’importe quel morceau de musique. Souvenez-vous de cet étrange sentiment où la raison nous dit qu’il ne s’agit de rien d’autre que d’une reconnaissance de forme permise par l’étalonnage en direct d’une immense base de donnée mais où ne ne pouvons nous empêcher d’exprimer un sentiment premier d’incrédulité.

Le même chose se produisit avec les « générateurs automatiques de textes » : si initialement rudimentaires aient été les premiers, si redoutablement complexes soient aujourd’hui ceux produits par des modèles de langage dopés à l’apprentissage profond comme GPT-3, à chaque fois lors de la découverte de leurs productions c’est le même sentiment d’étonnement ; ce trouble, momentané, où même en connaissant la réponse à la question de savoir comment cela est possible, il nous demeure pourtant impossible de l’envisager comme autre chose qu’une forme « magique ».

Il faut imaginer la tête du premier passant croisant une voiture dans la rue, la tête de celles et ceux allumant pour la première fois les toutes premières télévisions dans leur salon, se souvenir aussi de la réaction des premiers spectateurs et des premières spectatrices des toutes premières séances de cinéma et du train arrivant en gare de la Ciotat et qui reculèrent en ayant l’impression qu’il se dirigeait vers elles et eux. Un trouble toujours. Un étonnement souvent. Une inquiétude parfois. Un moment d’incrédulité d’autres fois.

Générateurs d’images et « d’oeuvres d’art » (sic).

Ces derniers mois ont vu croître et se multiplier des « intelligences artificielles » assez facilement accessibles au grand public et capables de produire des images élaborées, troublantes, étonnantes, magnifiques parfois, décevantes d’autres fois, images générées simplement à partir de quelques mots ou de quelques lignes de texte, à partir d’un « prompt ». Les plus connues et les plus récentes de ces IA s’appellent MidJourney, Stable Diffusion, Dall-E 2 et Dall-E mini.

Selon leur propre descriptif il ne s’agit de rien moins que de « nouveau(x) système(s) d’IA capable(s) de créer des images et des œuvres d’art réalistes à partir d’une description en langage naturel. »

Dans un article de décembre 2016 je revenais brièvement sur les origines de ce « langage naturel » comme interface et posais la question de savoir s’il était vraiment « naturel » de s’adresser à un algorithme en langage « naturel ». On peut aujourd’hui se demander ce qu’il y a de « naturel » à s’adresser à des intelligences artificielles en langage naturel pour créer … « des oeuvres d’art réalistes. »

Mais avant de poser cette question et bien d’autres, pour celles et ceux qui ne verraient pas de quoi je parle, voici d’abord quelques exemples que j’ai « générés » à l’aide de ces différents systèmes et en utilisant des « prompts » (des phrases quoi …) reprenant des incipit ou des citations littéraires.

Midjourney.

« Beau comme une rencontre fortuite sur une table mortuaire* d’une machine à coudre et d’un parapluie » (Lautréamont, Chants de Maldoror)

La citation originale parle d’une table de dissection mais le terme fait partie des mots et expressions non-utilisables par Midjourney (nous y reviendrons)

« C’était à Mégara, faubourg de Carthage, dans les jardins d’Hamilcar » (Flaubert, Salammbô)

« Dessine-moi un mouton » (Antoine de Saint-Exupéry, Le petit prince)

« Fini, c’est fini, ça va finir, ça va peut-être finir » (Beckett, Fin de partie)

Portrait of Samuel Beckett by Salvador Dali by Alberto Giacometti

« Aujourd’hui, maman est morte. Ou peut-être hier, je ne sais pas. » (Camus, L’étranger)

Très sincèrement, le générateur MidJourney est tout à fait bluffant esthétiquement et « interprétativement ». Malgré quelques incongruités, dont l’image de la femme sur le prompt de Fin de Partie.

Dall-E 2

Voici maintenant les mêmes phrases ou « prompts » mais testés dans l’outil d’Open AI baptisé Dall-E.

« Beau comme une rencontre fortuite sur une table mortuaire* d’une machine à coudre et d’un parapluie »

Portrait of Samuel Beckett by Salvador Dali by Alberto Giacometti

« C’était à Mégara, faubourg de Carthage, dans les jardins d’Hamilcar »

« Dessine-moi un mouton »

« Fini, c’est fini, ça va finir, ça va peut-être finir. »

« Aujourd’hui, maman est morte. Ou peut-être hier, je ne sais pas. »

On est ici dans un générateur qui prend un parti radicalement différent, éloigné de l’artistique au moins en première intention, et centré sur le trivial chaque fois qu’on l’y invite. Mais dès que l’on sort de prompts trivialement déclinables pour « jouer » avec les limites interprétables comme avec le « portrait de Samuel Beckett par Salvador Dali par Alberto Giacometti », les résultats sont là aussi souvent bluffants.

Stable Diffusion.

Cette fois je vous laisse retrouver l’ordre des prompts pour voir si vous suivez 😉

Enfin, un autre essai toujours sur Stable Diffusion, du prompt « Portrait of Samuel Beckett by Salvador Dali by Alberto Giacometti » mais en jouant sur les réglages plus fins proposés par l’outil et qui (en gros) proposent des curseurs pour réduire ou augmenter le niveau « d’interprétation » de la phrase choisie.

De gauche à droite, l’interprétation « standard » qui utilise les réglages par défaut de Stable Diffusion (« Inference Steps » et « Guidance Scale »), celle qui met les curseurs au minimum, et celle qui place les mêmes curseurs au maximum. Attention dans les termes que je choisis, lorsque je parle « d’interprétation » il s’agit en fait davantage d’une « itération », c’est à dire du nombre de fois ou le nombre de niveaux de « profondeur » où une instruction va être appliquée sur l’image initialement générée jusqu’à produire l’un de ses états présentés comme autant de « résultats ».

Une phraséologie.

Ce qui me frappe d’abord dans les innombrables tests que j’ai fait ou que j’ai observés chez d’autres et dans les résultats visibles et consultables pour chacun de ces outils, c’est le sentiment d’un « style », ou plus exactement d’une identité graphique presqu’immédiatement reconnaissable, de la plus « artistique » (Midjourney) à la plus triviale (Dall-E).

Une critériologie.

Chacun de ces générateurs dispose d’une série de critères de « réglages » plus ou moins accessibles en version publique. L’une des plus complètes de ce côté-là c’est DreamStudio Lite (émanation de Stable Diffusion) dont l’interface vous permet notamment de basculer entre différents « modèles » et cadres interprétatifs au sein du même générateur.

En variant le « sampler » utilisé on génère des représentations différentes, exactement comme lorsque l’on travaille des boucles dans le domaine musical ou des effets dans les logiciels de retouche d’image. Voici une série de variations autour du prompt « Portrait of Samuel Beckett by Salvador Dali by Alberto Giacometti » avec les 8 premiers samplers disponibles.

La question de la critériologie et des variations est essentielle si l’on prétend générer des images « intéressantes » au-delà de nos phraséologies plus ou moins subtiles et créatives. On voit ainsi apparaître de nouveaux outils en ligne qui répertorient, comme d’antiques annuaires de recherche, les principaux critères déclinables.

Noonshot propose ainsi un « prompt helper » qui vous permet d’utiliser différents critères pour les IA Midjourney et Dall-E, dont le nom de différents artistes pour en imiter le style.

Voici alors le résultat d’un prompt « augmenté » par une série de critères reconnus par Midjourney :

/imagine prompt:Aujourd’hui, maman est morte. Ou peut-être hier, je ne sais pas:: 16-bit::3.3 1800s::4.4 crepuscular rays::1 panorama::1 gustav klimt::1 matte black color::2.8 skin::1 defocus::-0.5 –ar 2:1 –quality 2 –stylize 20000

Et son résultat de génération graphique :

Chaque mot, mais aussi chaque critère peut ainsi être utilisé avec une pondération différente, laquelle pondération peut aussi dépendre de l’antériorité des autres critères choisis et de leurs propres pondérations. Il ne s’agit plus seulement de lancer des phrases à la volée et d’observer le résultat mais de les ouvrager dans un environnement technique et linguistique nécessitant un minimum d’apprentissage et renvoyant à des cadres interprétatifs et techniques élaborés.

Générer n’est pas nécessairement oeuvrer.

Ce qui est compliqué c’est la continuité. L’essentiel de ce que nous voyons la première fois que nous utilisons ces générateurs, relève du surgissement. Un peu comme lorsque l’on lance de la peinture sur une toile et que, parfois, le résultat donne l’image d’une composition artistique plutôt que d’une simple projection hasardeuse. Dès lors que l’on s’efforce de construire un récit, une narration, à l’aide de ces images générées, l’affaire se complique et réclame et nécessite un apport et un accompagnement qui ne laisse aucune ambiguïté sur l’origine de l’ambition artistique : elle relève bien de l’humain et non de la machine.

Si vous gardez un doute sur ce point, je vous invite à regarder le travail de l’artiste Alper Yesiltas, une série de 10 portraits de célébrités, travaillés à partir de générations d’images et intitulés « As If Nothing Happened. » On y retrouve Freddy Mercury, Lady Diana, Michael Jackson et quelques autres, « comme s’ils étaient encore vivants. »

Compte Instagram d’Alper Yesiltas.

Dans un entretien sur le site Bored Panda il explique :

La partie la plus difficile du processus de création pour moi est de faire en sorte que l’image me semble « réelle ». Le moment que j’apprécie le plus est celui où l’image devant moi me semble très réaliste, comme si elle avait été prise par un photographe. J’utilise différents logiciels. Le temps qu’il me faut pour créer une image entièrement terminée varie, mais je dirais qu’il faut un certain temps pour qu’une image me paraisse « réelle ».

Les 10 portraits, d’un réalisme saisissant, n’ont rien à voir avec les applications qui vous proposent de générer automatiquement des images de vous vieilli, et aucune génération automatique d’image n’est aujourd’hui capable, sans intervention humaine, d’offrir un réalisme qui n’est pas uniquement celui du « grain » mais qui tient aussi à l’intention et à la composition de l’ensemble du portrait.

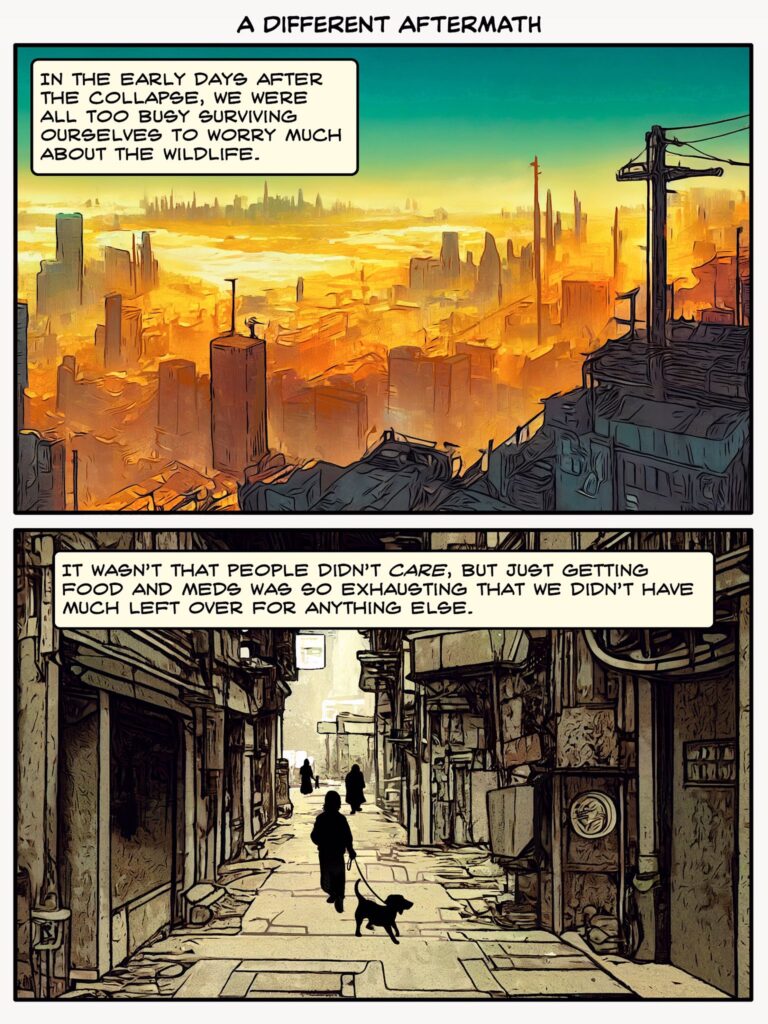

Autre exemple, celui de l’autrice Ursula Vernon qui a entièrement conçu à l’aide de Midjourney une bande-dessinée de quelques planches, et qui explique dans cette tirade (ce Thread) pourquoi cela fut extrêmement long et compliqué (en gros parce qu’elle passa énormément de temps à retoucher, modifier les dessins générés par l’IA qui n’étaient jamais suffisamment proches de l’image mentale qu’elle en avait).

La planche d’ouverture.

La planche d’ouverture.

Impossible de connaître la part de l’image automatiquement générée

et celle du travail de l’artiste pour en faire ce que nous voyons ici.

Mais il existe déjà des oeuvres abouties qui tirent parti de ces générateurs, et ce dans un cercle vertueux autour du domaine public. C’est par exemple le cas de Star Maker d’Olaf Stapledon (publié pour la première fois en 1937 et donc dans le domaine public) et qui a été entièrement réimaginé sous forme de roman graphique à l’aide de Midjourney.

Et si l’on se contente du surgissement ? Si l’on omet ou si l’on oublie le travail d’un.e artiste qui voudrait en faire quelque chose et prendrait le temps nécessaire pour y parvenir ?

Alors ce surgissement est aussi la confrontation avec une altérité que nous testons et que nous affrontons pour en dessiner les limites. En oubliant parfois que ces limites que nous voyons à la capacité de la machine renvoient d’abord à celles de nos imaginations. Souvenez-vous des premiers mots, des premiers dialogues, des premiers « prompts » que vous avez adressé à Siri, à Alexa ou à « Ok Google », comme pour les piéger, les déstabiliser, les mettre devant leurs limites de compréhension qui sont aussi souvent celles de nos appréhensions. Le langage est une interface qui tient à ce qu’il y a à la fois de plus rudimentaire dans l’interaction et de plus élaboré dans sa potentialisation.

L’IA est-elle l’avenir de l’art ?

Et pour autant qu’il y ait des intelligences artificielles, peuvent-elles être artistiques ? Des intelligences artificielles artistiques ? Des artifices artificiellement intelligents ? Comme dans toute révolution ou évolution technique, trois horizons d’attente coexistent : il y a ce que l’on fantasme qu’il adviendra, il y a ce qu’il advient vraiment, et il y a tout ce qui advient mais que l’on n’avait pas prévu, ou pas comme ça, ou pas si vite, ou pas dans ces termes là.

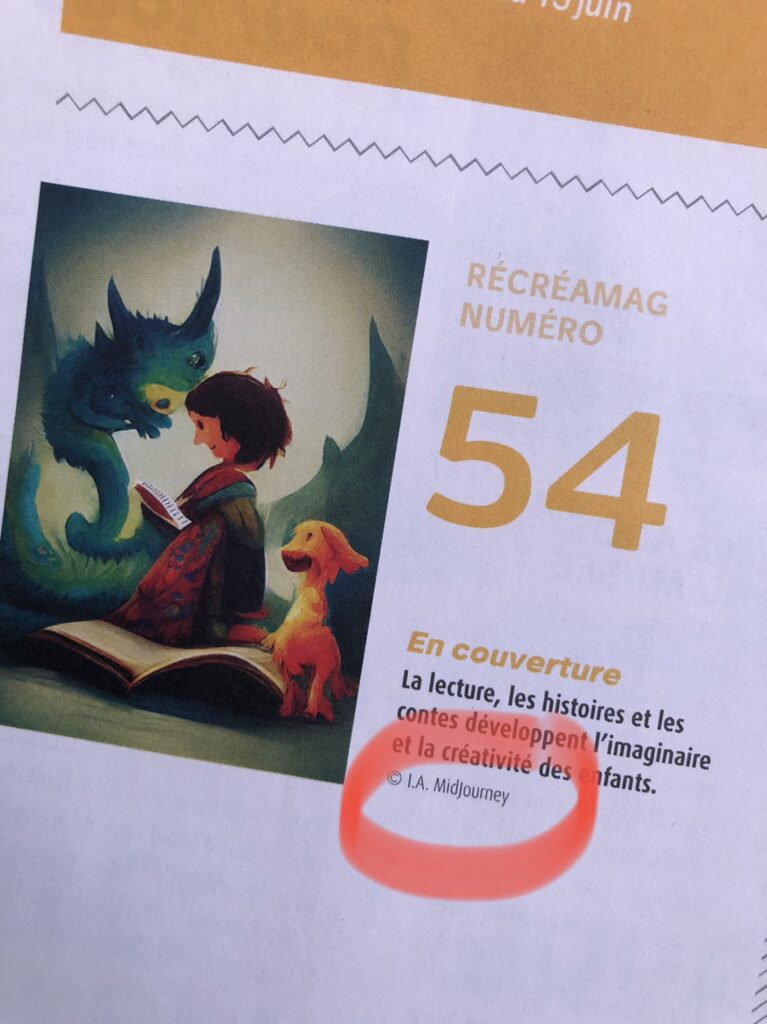

Ce dont nous sommes sûrs, c’est que la « facilité » et la rapidité d’une génération circonstancielle va en effet trouver un grand nombre d’usages illustratifs (dans la presse et les médias en général). Exemple avec une revue de l’agglomération Grenobloise qui fit sa Une avec une illustration de l’IA Midjourney :

(Repéré sur Twitter par FuzzyRaptor)

Ce dont nous sommes également sûrs c’est que la facilité et la gratuité d’aujourd’hui auront tôt fait de se transformer en licences d’usage plus ou moins coûteuses.

Ce dont nous sommes sûrs encore, c’est que l’articulation de ces créations au régime du droit d’auteur ne se fera ni sans heurts ni sans passionnants débats. Savoir ce qui fait oeuvre, connaître la part de l’auteur et celle résiduelle ou centrale de la génération, génération qui elle-même ne se fait jamais sans « autorité » (ou autoritativité) ou sans intentionnalité …

Ce dont nous sommes sûrs enfin, c’est que les chaînes de décision et de responsabilité vont comme à chaque avancée numérique majeure, continuer de se diluer et si nous n’y prenons garde, de se déliter. Qui est responsable de la génération elle-même mais aussi du statut publiable et diffusable de celle-ci ? Celui ou celle qui a tapé le « prompt » ? Le propriétaire – s’il y en a un – de la base d’images l’ayant permis ? Celles et ceux qui ont programmé et réglé l’algorithme utilisé pour la génération ? Celles et ceux qui ont constitué et travaillé sur les jeux de données (datasets) sans lesquels il n’y aurait pas de génération possible ?

Dans l’histoire de l’art nombreuses furent les périodes ou peintres, sculpteurs, musiciens, et même auteurs disposaient souvent de petites mains au service de la préparation de leurs toiles ou des blocs de pierre qu’ils taillaient ensuite pour leur donner vie. Nombreux et nombreuses furent toujours les oublié.e.s dans l’ombre de ces noms aujourd’hui passés à la postérité. Depuis que l’on réfléchit à la question du numérique dans ses processus créatifs ou génératifs, on parle d’agencements collectifs d’énonciation (ACE). Ces agencements demeurent. Il faut leur adjoindre des agencements collectifs de génération (ACG). La question, la grande question est celle de savoir comment les deux s’articulent, comment ils s’imbriquent, comment ils travaillent ensemble et dans quelle temporalité, avec quelle intentionnalité.

L’oeuvre ouverte.

A côtoyer ces générateurs, à la manipuler par la langue, on a tôt fait de se prendre pour un créateur et de s’imaginer artiste. Peut-être l’est-on d’ailleurs dans le sens où Umberto Eco parlait de l’oeuvre ouverte.

Parmi les compositions de musique instrumentale les plus récentes, il en est un certain nombre qui se caractérisent par l’extraordinaire liberté qu’elles accordent à l’exécutant. Celui-ci n’a plus seulement, comme dans la musique traditionnelle, la faculté d’interpréter selon sa propre sensibilité les indications du compositeur : il doit agir sur la structure même de l’œuvre, déterminer la durée des notes ou la succession des sons, dans un acte d’improvisation créatrice. (…) Ces quatre exemples, choisis parmi beaucoup d’autres, révèlent la distance considérable qui sépare de pareils modes de communication musicale de ceux auxquels nous avait habitués la tradition. Une œuvre musicale classique —une fugue de Bach, Aïda, ou le Sacre du Printemps — est un ensemble de réalités sonores que l’auteur organise de façon immuable ; il les traduit en signes conventionnels pour permettre à l’exécutant de retrouver (plus ou moins fidèlement) la forme qu’il a conçue. Au contraire, les œuvres musicales dont nous venons de parler ne constituent pas des messages achevés et définis, des formes déterminées une fois pour toutes. Nous ne sommes plus devant des œuvres qui demandent à être repensées et revécues dans une direction structurale donnée, mais bien devant des œuvres « ouvertes », que l’interprète accomplit au moment même où il en assume la médiation.

Et plus loin de poursuivre et de conclure :

Les esthéticiens parlent parfois de « l’achèvement » et de l’ « ouverture » de l’oeuvre d’art, pour éclairer ce qui se passe au moment de la « consommation » de l’objet esthétique. Une œuvre d’art est d’un côté un objet dont on peut retrouver la forme originelle, telle qu’elle a été conçue par l’auteur, à travers la configuration des effets qu’elle produit sur l’intelligence et la sensibilité du consommateur : ainsi l’auteur crée-t-il une forme achevée afin qu’elle soit goûtée et comprise telle qu’il l’a voulue. Mais d’un autre côté, en réagissant à la constellation des stimuli, en essayant d’apercevoir et de comprendre leurs relations, chaque consommateur exerce une sensibilité personnelle, une culture déterminée, des goûts, des tendances, des préjugés qui orientent sa jouissance dans une perspective qui lui est propre. Au fond, une forme est esthétiquement valable justement dans la mesure où elle peut être envisagée et comprise selon des perspectives multiples, où elle manifeste une grande variété d’aspects et de résonances sans jamais cesser d’être elle-même. (Un panneau de signalisation routière ne peut, au contraire, être envisagé que sous un seul aspect ; le soumettre à une interprétation fantaisiste, ce serait lui retirer jusqu’à sa définition.)

Umberto Eco écrit encore :

L’ouverture suppose finalement l’organisation minutieuse et calculée d’un champ de possibilités.

C’est très littéralement, très exactement ce que ces intelligences artificielles « capable(s) de créer des images et des œuvres d’art réalistes à partir d’une description en langage naturel » nous proposent aujourd’hui : l’organisation minutieuse et calculée d’un champ de possibilités.

Le paradoxe du singe savant (que Borges utilise et détourne dans sa nouvelle « La bibliothèque de Babel ») part du principe qu’en tapant au hasard sur un clavier un singe pourra presque sûrement écrire un texte donné. Borges renverse la perspective en imaginant une bibliothèque dans laquelle tous les textes possibles à écrire ont déjà été écrits, et qu’il ne s’agit plus que de retrouver ceux qui font sens, et parmi ceux qui font sens ceux qui ont une valeur esthétique, littéraire, historique, etc. L’état actuel des dispositifs de génération d’images à partir de phrases nous place dans l’état d’être l’un.e des bibliothécaires de Babel. L’immensité des jeux de données (datasets) utilisés par Dall-E, Midjourney, Stable Diffusion et quelques autres, est à notre échelle une immensité littéralement « im-perceptible », que nous ne sommes pas en capacité de percevoir et de traiter comme une totalité. Seuls des dispositifs calculatoires en ont une vision « holistique ». Nous n’avons donc en partie pas d’autre choix que de faire confiance à ces dispositifs calculatoires pour produire des inférences dont certaines viendront combler nos esthétiques espérances.

Plus globalement c’est toute une nouvelle synesthésie liée aux interactions numériques qui se met en place. Nous parlions déjà à des objets connectés (enceintes, téléphones …), ces objets sont aujourd’hui également capables d’interpréter notre regard et de se dispenser de la « phrase d’activation », et il est donc désormais possible de produire des images avec des mots, avec la voix. Plus que jamais un nouveau tournant majeur dans ce que je chronique depuis 2012 sous le terme générique du « World Wide Voice ».

Parler à des objets, parler à des moteurs de recherche, parler à des générateurs d’images, s’adresser à des bases de données, c’est assez trivialement comme parler à des … gens. Il faut s’assurer d’une langue commune, s’assurer d’un niveau de langue adapté à l’âge de l’interlocuteur et au contexte du dialogue, il faut ajuster aussi le volume et être capable en permanence de hausser le ton ou de parler plus bas. C’est une boucle de rétroaction permanente et complexe. Ce que ne sont pas encore et que ne seront d’ailleurs jamais probablement les « dialogues » que nous avons avec des intelligences artificielles. Sauf pour celles et ceux qui en feront leur métier (designers, photographes, réalisateurs, auteurs …) ou qui s’en serviront comme d’une matière artistique manipulant les critériologies langagières et techniques comme les peintres leur palette de couleurs.

Et puis à la fin, pourquoi génère-t-on des images autrement que pour l’initial plaisir de tester un rendu ? Comment qualifier la vanité de ce plaisir de constituer ces éphémère cabinets de curiosités personnelles ? Et que deviendront ces générations que nous abandonnons dès leur naissance mais qui pour les sociétés qui nous permettent de le faire, demeurent capitalisables, puisque nos choix, y compris de les délaisser ou de les abandonner, sont signifiants et sont un indice parmi tant d’autres d’une réutilisation possible ?

Inpainting et Outpainting.

Ces technologies de l’artefact sont celles qui rendent possible, pour l’amateur, la création de représentations volontairement altérées et artificielles de la réalité dans une recherche (une « mimesis ») de la vraisemblance. Parmi ces technologies de l’artefact (…) on pourra citer en exemple les « Photoshop Naked Contest« , les « Fake Vidéos » (comme celle de l’étoile noire volant au dessus de San Francisco), cette application permettant à tout le monde de vieillir instantanément une photo, les guerres d’édition et les tentatives de redocumentarisation déviantes sur Wikipedia. Ces technologies de l’artefact réclament d’urgence la construction d’une heuristique de la preuve, de la traçabilité de la preuve, une heuristique qui tienne compte de ces phénomènes, qui les explicite, et qui permette (c’est le plus délicat) de les « monitorer » non pas tant en temps réel mais bien a posteriori, c’est à dire dans l’optique d’une rétro-ingénierie documentaire.

Là encore et même si l’exemple ci-dessus n’est pas particulièrement inquiétant parce que particulièrement bâclé, il nous faudra aussi voir ce que la génération de ces images « promptement » modifiées de l’intérieur basculer dans nos heuristiques de preuve.

La question se pose naturellement de la vérité ou de la véracité des images ainsi générées dans nos quotidiens consuméristes. Mais elle se pose aussi à l’échelle médiatique où l’image est de facto le plus souvent présentée comme un élément de preuve auto-légitimant. Et elle se pose enfin dans la mère de tous les domaines, celui de la recherche scientifique. Domaine où, comme le faisait remarquer un collègue biologiste, Vittorio Saggiomo, sur Twitter :

« Image d’une fourmi au microscope électronique » #dalle2 Aucune de ces images n’est réelle…. elles sont générées par ordinateur….

bonne chance avec la méconduite scientifique…..

Ce qui est ici particulièrement troublant c’est en quelque sorte l’intrication quantique de ces « images-preuves ». Quand Vittoria Saggiomo écrit « qu’aucune de ces images n’est réelle« , il a raison (et il a aussi raison d’en pointer le risque dans les pratiques scientifiques). Mais on peut aussi considérer qu’il a en partie tort puisque ces images de fourmis qui n’existent pas s’appuient sur des images de fourmis au microscope électroniques déjà existantes. Et que ces images de fourmis au microscope électronique peuvent avoir un usage scientifique dès lors qu’elles s’accompagnent d’une déontologie qui explicite et précise les conditions de leur génération et qui encadre l’usage qu’il est possible d’en faire.

Une nouvelle fois la question des technologies de l’artefact et de leurs heuristiques de preuve est centrale … et urgente. La trahison des images, saison 2.

Prompte fut la bourse des prompts.

Si comme le dit le proverbe populaire, « une image vaut mille mots« , alors combien vaut le mot capable de produire mille images ?

« Karl Marx as a Venture Capitalist » (Midjourney)

Le capitalisme linguistique ne connaît aucune limite, seulement des bifurcations. Il ne falllut donc pas attendre très longtemps avant que de voir naître une « place de marché » des prompts. Le site « Promptbase » affiche une promesse simple :

« Trouvez les meilleurs prompts, produisez de meilleurs résultats, économisez sur les coûts d’API, vendez vos propres prompts. »

Si l’idée de vendre des mots aux enchères à des annonceurs fit florès, l’idée de vendre des phrases à des individus peut apparaître saugrenue. Elle cesse (en partie) de l’être si l’on considère qu’un « prompt » n’est pas une simple phrase mais une série plus ou moins complexe d’instructions cohérentes disposant chacune de paramétrages distincts adaptés à des jeux de données ciblés et disposant eux-mêmes de processus de constitution et de génération particuliers. Ce que l’on vend n’est donc pas la phrase ou l’idée derrière la phrase, mais son applicabilité déjà testée et déclinable dans tel ou tel générateur à base d’intelligence artificielle. Et ce que l’on achète est donc une API, c’est à dire « un ensemble normalisé de classes, de méthodes, de fonctions et de constantes qui sert de façade par laquelle un logiciel offre des services à d’autres logiciels. » (Wikipédia)

Pour ne prendre qu’un seul exemple, voici ce que donne le prompt « Pixar Hipster Animals » dans Midjourney :

Et voici ce que l’achat du prompt détaillé dans Promptbase permet de générer :

L’achat de ce prompt vous coûtera 1,99$. Notez que pour le prix du prompt, il vous faudra ajouter celui de l’accès à la base Midjourney qui n’est pas inclus : tous ces générateurs (Midjourney, Dall-E, etc) ne sont accessibles gratuitement que dans un premier temps, vous permettant un certain nombre d’essais au-delà desquels il vous faudra passer à une version payante.

Le prix des prompts disponibles dans Promptbase varie et peut monter (je n’ai pas fait de recherche exhaustive) jusqu’à au moins 5,99$.

On touche alors au problème le plus communément soulevé dès lors que l’on évoque ces nouvelles technologies de génération d’images : celui du droit d’auteur. Problème qui peut être ainsi sommairement résumé : qui est l’auteur des générations finalisées ?

Est-ce le programme informatique et/ou ses programmateurs servant de base à la génération ? Est-ce le « prompteur », c’est à dire celui ou celle qui a l’idée de la phrase et paramètre la critériologie (API) correspondante ? Et quid des auteurs des photos et images initialement disponibles pour la génération et sans lesquelles elle devient impossible ? Quid du « statut » de ces images prétextes, pré-icôniques ? Et si nous sommes les auteurs de ces images utilisées dans les différents jeux de données, comment sait-on que nos images y figurent et comment les en retirer (Opt-Out) ? Il est impossible de répondre à cette question en dehors du cadre qui est celui de l’Oeuvre Ouverte d’Eco et des autres points que j’évoquais plus haut dans cet article.

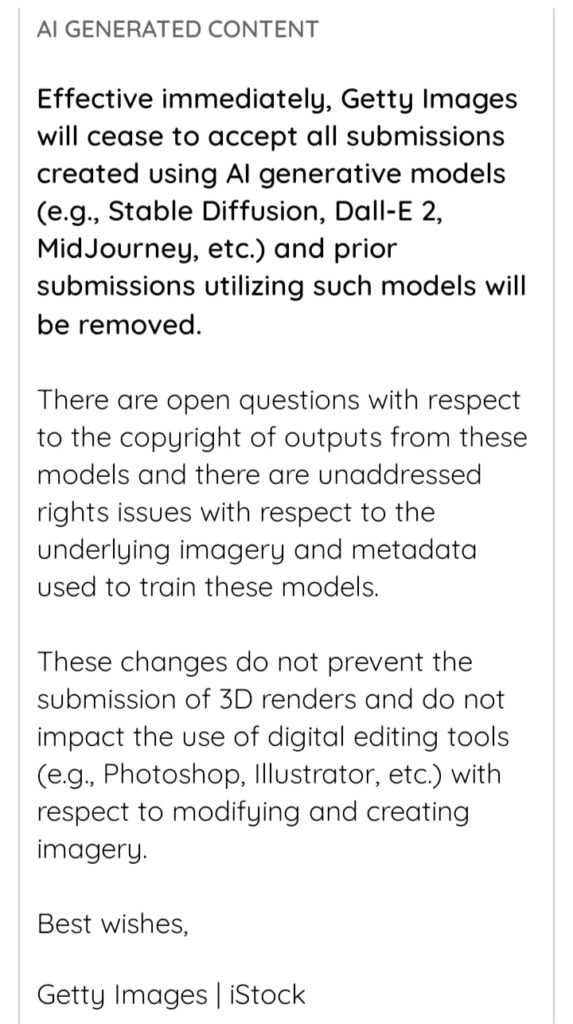

Mais de manière triviale on notera déjà que « le marché » par la voix de Getty Images indique qu’il n’acceptera pas d’intégrer à son offre commerciale les images générées artificiellement.

Si la question est aussi complexe c’est que les CGU (conditions générales d’utilisation) des plateformes elles-mêmes diffèrent grandement. Du côté de Midjourney on indique :

vous êtes propriétaire de tous les actifs que vous créez, avec la réserve que l’utilisateur accorde à la société une large licence pour utiliser non seulement les images générées par l’IA que l’utilisateur produit, mais aussi les invites textuelles de l’utilisateur utilisées pour générer les images.

Donc en gros vous êtes surtout … co-propriétaire 😉

A l’inverse, du côté de Dall-E (OpenAI) :

OpenAI est propriétaire de toutes les générations créées sur la plateforme, et n’accorde aux utilisateurs que le droit d’utiliser et de revendiquer des droits d’auteur sur leurs images générées par l’IA.

Stable Diffusion fait un choix radicalement différent qui est celui du … domaine public, ou plus exactement de la licence Creative Commons Domaine Public.

Tous les utilisateurs, par l’utilisation de DreamStudio Beta et du service Discord Stable Diffusion beta reconnaissent par la présente avoir lu et accepté l’intégralité du CC0 1.0 Universal Public Domain Dedication qui inclut, mais n’est pas limité, à la renonciation précédente des droits de propriété intellectuelle concernant tout contenu. L’utilisateur, par l’utilisation de DreamStudio Beta et du service Discord Stable Diffusion beta, reconnaît comprendre qu’une telle renonciation inclut également une renonciation à l’attente et/ou à la réclamation d’un tel utilisateur à tout droit absolu, inconditionnel de reproduire, copier, préparer des travaux dérivés, distribuer, vendre, exécuter, et/ou afficher, comme applicable, et en outre qu’un tel utilisateur ne reconnaît aucune autorité ou droit de refuser la permission à d’autres de faire la même chose concernant le contenu. Tout utilisateur renonce par la présente et ne détient aucun droit, quel qu’il soit et quelle que soit la juridiction, sur le contenu. En outre, tous ces utilisateurs reconnaissent par la présente que les présentes conditions d’utilisation lieront tous les successeurs, héritiers, agents, affiliés, administrateurs, représentants, avocats, exécuteurs, divisions et cessionnaires de l’utilisateur, maintenant et pour toujours. En outre, cette renonciation libère, acquitte et décharge irrévocablement et pour toujours Stability AI LTD de toute réclamation, demande, charge, plainte, controverse, accord, promesse et cause d’action de quelque nature que ce soit, en droit et en équité, connue ou inconnue, soupçonnée ou insoupçonnée, découlant du contenu et s’y rapportant de quelque manière que ce soit.

Jeux interdits.

A la grande bourse capitalistique des mots et des phrases, des images et des textes, il en est d’interdits. Jeux de mots, jeux de données, interdits. Vous ne pourrez pas utiliser dans vos prompts ce qui est considéré comme « NSFW » (Not Safe For Work). Mais vous ne pourrez pas non plus utiliser le terme de dissection (susceptible de créer des images trop « choquantes »). Et si vous pouvez demander à générer des images à la manière de Dali, Warhol, Banksy, Frida Kahlo, Degas, Goya, Bacon et quelques dizaines d’autres, vous ne pourrez pas en revanche le faire à la manière de Philippe Starck puisque son nom, qui est aussi sa marque, font partie des mots interdits dans les prompts.

Extrait des choix proposés par https://prompt.noonshot.com/midjourney

Comme le faisait remarquer Antonio Casilli :

Dall-E 2 a un problème de censure. Les examinateurs humains suppriment le contenu en temps réel. Ils sont *obsédés* par les nus, les deepfakes, la haine. Mais leur notion d’images problématiques est… spéciale. Par exemple, j’ai essayé de demander « Lénine et Staline jouant au volleyball » 👉 ils ont menacé de me bannir !

De fait « Lenine et Staline playing Volleyball » est interdit (« It looks like this request may not follow our content policy« ) mais « Lenine playing Volleyball » ou « Soviet Suprem playing Volleyball » ça passe crème. La preuve.

« Lenine playing Volleyball » (Dall-e)

« Soviet Suprem playing Volleyball » (Dall-e)

C’est donc Staline le méchant. Et le camarade Lénine a quant à lui sacrément changé. Un petit test avec Hitler et Mussolini qui jouent au Volley ? Sans surprise Hitler est le mot interdit. Et Mussolini est à l’image de Lénine assez librement réinterprété.

« Mussolini playing Volleyball » (Dall-e)

Il faut noter qu’Emmanuel Macron ou Barack Obama sont également interdits (sans rapport donc avec les précédents interdits mais tout aussi problématique sur le fond).

Voici maintenant les mêmes scripts mais sur Stable Diffusion :

« Lenine and Staline playing Volleyball » (Stable Diffusion)

« Hitler and Mussolini playing Volleyball » (Stable Diffusion)

On pourrait aussi discuter des heures de ces pudeurs algorithmiques de l’IA qui consistent soit à travestir totalement la figure d’un ancien dictateur, soit à le transformer en femme (!), soit à lui mettre un objet (ici un ballon) devant le visage pour n’avoir pas à le représenter. Mais aucune intelligence artificielle à ce jour n’est donc capable de générer ce genre d’images en tout cas tant qu’elle accepte une liste de mots interdits :

« Le conquérant » Joseph Steib.

« La Dernière Scène » Joseph Steib. 1943, huile sur bois

C’est donc un pan entier de la caricature, du dessin et de l’art politique, qui se trouve ainsi « exclu » du champ de « l’organisation minutieuse et calculée d’un champ de possibilités. »

Qui va définir la liste des mots interdits ? Les prompts impossibles ? Et au nom de quels critères, de quelles règles et de quelles normes ? Il est à craindre en l’état du marché de ces générateurs, que ce soient une nouvelle fois les CGU seules (Conditions Générales d’Utilisation), c’est à dire les dimensions règlementaires et contractuelle qui l’emportent sur – par exemple – la loi ou sur le simple bon sens. A l’entière discrétion des plateformes les mettant en oeuvre.

Et nous allons bientôt découvrir un nouveau cycle dans lequel nous interrogerons l’interdiction de tel ou tel mot et des images associées, comme nous l’avions fait dans un cycle numérique précédent à propos, par exemple des régies publicitaires des moteurs de recherche à l’ère du capitalisme linguistique. Il serait bon que nous n’attendions pas cette fois les premières dérives pour nous doter d’un cadre législatif mais surtout intellectuel qui ne soit pas à l’initiative seule des firmes qui détiennent et exploitent ces technologies. Mais l’enjeu demeure vertigineux. Que peut-il advenir d’une génération basée sur l’intelligence artificielle sur un prompt comme « avortement » ? Ou sur le mot « Shoah » ? Que faut-il faire de ces générations là ? Google eut à répondre de l’entrée de ces deux termes dans la grande bourse spéculative des mots qu’il construisit à grand coup d’algorithme. Avec à chaque fois l’obligation de réagir dans un contexte d’urgence où précisément l’instrumentalisation marchande de tels signifiés représentait un déchirement insupportable dans le tissu social de nos histoires communes.

« Moyennant finance, il est possible de changer significativement et durablement les résultats répondant à la requête « L’Holocauste a-t-il vraiment existé » pour faire en sorte que le moteur n’affiche plus que des thèses révisionnistes en première page. Avant l’histoire de l’Holocauste, c’étaient les lobbys religieux anti-avortement qui à grands coups de budget publicitaire rendaient « invisibles » les résultats liés au planning familial et à l’information sur l’IVG. A chaque fois les dégâts ont été immenses. A chaque fois Google s’est excusé. A chaque fois il a tenté de régler le problème. Et à chaque fois le problème s’est reproduit. Sur un autre sujet, à une autre échelle, dans une autre plateforme, et avec à chaque fois un impact encore plus grand. Et cela ne cessera jamais. Jamais. Et aucun des fondateurs de Google ne renoncera à court terme au modèle économique de leur moteur, ce même modèle dont ils avaient pourtant magistralement analysé la dangerosité lorsqu’ils étaient en train de l’inventer. » in Affordance.info

La question n’est pas tant de savoir quels mots il nous faut exclure de la possibilité d’être « promptés » et au nom de quels principes il nous faudrait le faire, mais plutôt de savoir à quelle(s) économie(s) matérielle(s) et symbolique(s) il nous faut nous préparer à renoncer pour continuer d’avancer dans un monde qui soit encore à la fois regardable par chacun et montrable à tous et toutes.

Et sans même parler de dictateurs jouant au Volley ou de prompts salaces ou virant à l’ignoble, quel est le prompt d’un simple … baiser ?

Comment les pudeurs normatives s’appliquent-elles à rendre représentable ou irreprésentable ce point rose qu’on met sur l’i du verbe aimer, ce secret qui prend la bouche pour oreille, cet un instant d’infini qui fait un bruit d’abeille, cette communion ayant un goût de fleur, cette façon d’un peu se respirer le coeur, et d’un peu se goûter, au bord des lèvres, l’âme** ? Pour y répondre il vous faut lire le passionnant texte du chercheur Eryk Salvaggio, « The datafication of a kiss » et son écho chez Olivier Auber (« Le baiser artificiel »). Ou comme le résume encore le chercheur Matthieu Triclot à partir de l’article d’Eryk Salvaggio :

Une image générée par IA n’est pas une image, c’est une infographie qui exprime les propriétés de son dataset.

« studio photography of humans kissing » (Dall-e)

Il n’est pas que des mots interdits, il est aussi des idées irreprésentables selon le jeu de données utilisé et la société qui en est propriétaire :

OpenAI vous donnera un avertissement de contenu si vous tentez de créer des images représentant des images pornographiques, violentes ou haineuses. Si vous demandez une image de deux hommes s’embrassant, il crée une image de deux hommes s’embrassant. Si vous demandez une image de deux femmes s’embrassant, vous recevez une alerte (flag) pour avoir demandé un contenu explicite. Nous avons donc un exemple très clair de la manière dont les valeurs culturelles s’inscrivent dans l’imagerie de l’IA. Tout d’abord, à travers l’ensemble de données et ce qui est collecté et formé. Ensuite, par des interventions dans ce qui peut être demandé.

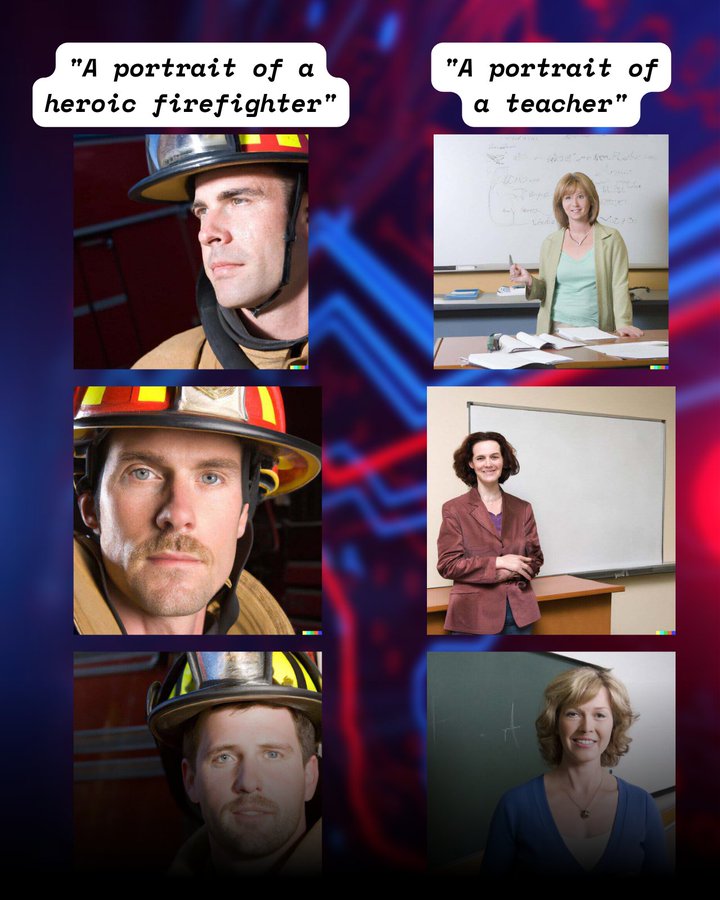

La question du faux et des valeurs culturelles « implicites » rencontre immédiatement celle des (nombreux) biais dont sont peuplées ces intelligences artificielles et les jeux de données qui les constituent. Souvenez-vous de l’attaque des perroquets stochastiques, et lisez cet excellent thread de Matthis Hammel.

Or face aux si désespérément classiques, constantes et consternantes stéréotypies et autres processus d’invisibilisation, voici la manière dont les sociétés les traitent :

[** vous aurez reconnu la tirade de Cyrano de Bergerac dont je vous invite à découvrir la poétique des prompts qu’elle permet aussi de générer]

Jeux de données, Datasets (et match).

Stable Diffusion utilise un jeu de données baptisé LAION Aesthetics V2.

Laion aesthetic est un sous-ensemble de laion5B qui a été estimé comme étant esthétique par un modèle entraîné sur la base d’extraits associés. L’utilisation prévue de ce jeu de données est la génération d’images.

Et LAION 5B c’est :

Un jeu de données composé de 5,85 milliards de paires image-texte filtrées par CLIP*, comprenant plusieurs indices de plus proches voisins, une interface web améliorée pour l’exploration et la génération de sous-ensembles, et des scores de détection de filigrane, NSFW et de contenu toxique.

* « CLIP est un réseau de neurones qui apprend des concepts visuels à partir d’une supervision en langage naturel. »

Du côté de DALL-E on a la mise en oeuvre multimodale de GPT-3 (un modèle de langage – réseau de neurones – capable de (re)produire des textes et des scripts conversationnels) « avec 12 milliards de paramètres qui » échange du texte contre des pixels « , entraîné sur des paires texte-image provenant d’Internet. DALL-E 2 utilise 3,5 milliards de paramètres. » (Wikipédia)

Et concernant Midjourney … je n’ai pas trouvé mais les commentaires sont ouverts 😉

Naissance d’un capitalisme sémiotique.

Dans le monde numérique qui s’ouvre aujourd’hui et dans les potentialités qu’il déploie, entre le fantasme d’une translation totale dans un métavers (réalité virtuelle) et celui d’une augmentation systématique de chaque lieu, de chaque objet ou de chaque signe (réalité augmentée), se dresse et s’intercale aujourd’hui un peuple de prompteurs et de prompteuses, cherchant encore sa place et sa légitimité dans la classe vectorialiste constituée.

« Ici, dans le monde surdéveloppé, la bourgeoisie est morte. Elle a cessé de régir et de gouverner. Le pouvoir est aux mains de ce que j’ai appelé la classe vectorialiste. Alors que la vieille classe dominante contrôlait les moyens de production, la nouvelle classe dominante éprouve un intérêt limité pour les conditions matérielles de la production, pour les mines, hauts fourneaux et chaînes de montage. Son pouvoir ne repose pas sur la propriété de ces choses, mais sur le contrôle de la logistique, sur la manière dont elles sont gérées. Le pouvoir vectoriel présente deux aspects, intensif et extensif. Le vecteur intensif est le pouvoir de calcul. C’est le pouvoir de modéliser et simuler. C’est le pouvoir de surveiller et calculer. Et c’est aussi le pouvoir de jouer avec l’information, de la transformer en récit et poésie. Le vecteur extensif est le pouvoir de déplacer l’information d’un endroit à un autre. C’est le pouvoir de déplacer et combiner chaque chose avec toute autre chose en tant que ressource. Encore une fois, ce pouvoir n’a pas uniquement un aspect rationnel, mais aussi poétique. »

Wark McKenzie, Degoutin Christophe, « Nouvelles stratégies de la classe vectorialiste », Multitudes, 2013/3 (n° 54), p. 191-198.

Il y a bien une poétique, qui est aussi une noétique, de ces productions artificielles contrôlées par la langue. Mais cette poétique s’articule déjà très bien, trop bien peut-être, avec une pragmatique capitalistique qui vise à épuiser les possibilités mêmes de la spéculation.

La question d’un monde réagissant à la voix, la question de productions icôniques ou audiovisuelles sans limite et dont la simplicité de la génération masque entièrement le coût exorbitant de production, la question enfin du statut de ces productions dans l’ensemble des heuristiques de preuve sans lesquelles une société ne peut pas tenir ou s’éviter de sombrer dans le chaos, toutes ces questions restent aujourd’hui posées.

Pendant très longtemps (depuis les débuts du numérique) la question de la profusion des images ne fût pensée qu’en termes de capacité (et de capitalisme) de surveillance. Il fallait être en capacité de produire des images de situations et d’individus (vidéo-surveillance) pour les surveiller d’abord rétroactivement (les retrouver) puis de manière pro-active (en temps réel). Aujourd’hui cette fatrasie instrumentale d’images, qui n’a besoin comme révélateur que de la langue commune, oblige à questionner différemment y compris les questions régaliennes du capitalisme de surveillance.

Frédéric Kaplan avait parfaitement décrit ce qu’était l’invention d’un capitalisme linguistique et ce qui fut et demeure un bouleversement aussi inédit que radical à l’échelle des sociétés humaines. Ce que nous observons aujourd’hui est sa prochaine mue et son prochain avènement : celui d’un capitalisme sémiotique** total englobant à la fois, comme chez Pierce, le signe, l’objet et l’interprétant (qu’il soit humain ou code calculatoire).

[** influencé par les travaux de Guattari dans les années 1970, le philosophe italien Franco Berardi a forgé dans les années 1990 le concept de « sémiocapitalisme » pour désigner une forme de capitalisme opérant sémiotiquement.]

Toutes ces images produites, générées, vont à leur tour désormais entrer dans de complexes processus de normativité, principalement alignés sur les intérêts de la classe vectorialiste. C’est l’ensemble des systèmes de signes qui fondent une nouvelle étape du Capitalocène. Avec la performativité de la langue érigée en paradigme non-négociable. Ce qui est formulé, verbalisé, mise en mot, doit pouvoir exister visuellement. Et ce quel que soit le prix de la performance.

La notion de « générativité« , utilisée ici pour désigner le cycle de production et de réception de ces images, existe aussi dans le champ de la psychologie sociale depuis les années 1950 où elle fut introduite par Erikson dans le cadre de sa théorie du cycle de vie de l’humain, et elle désigne l’importance accordée au bien-être des générations futures.

C’est peut-être, c’est même certainement avec ce regard là que nous devons commencer de réfléchir au statut de ces productions documentaires inédites : non pas uniquement pour ce qu’elles sont, mais essentiellement pour ce qu’elles … lègueront.

Apostille.

L’idée de cet article et nombre de ses réflexions doivent beaucoup au travail et aux publications d’Etienne Mineur sur le sujet, que je vous invite à lire, notamment les 2 articles qu’il consacre au sujet sur son blog (« Réflexions provisoires consacrées aux IA » et « Intelligences artificielles et Design dans les écoles en 2020« ), à parcourir et à admirer aussi dans sa dimension créative comme pour ses typographies artificielles.

Dans un de ses posts Facebook, que je reprends ci-dessous, il liste diverses initiatives concurrentes ou en tout cas co-occurentes aux trois déjà géants que sont Dall-E, Midjourney et Stable Diffusion, dont :

- Phénaki qui permet de générer des vidéos à partir d’un texte.

- Nvidia avec son Neural Reconstruction Engine (aussi en 3D) et aussi avec Canvas

- un outil permettant de générer / dessiner directement des portraits en 3D.

- Jasper, outil de génération d’images artistiques mais aussi de textes optimisés pour le SEO …

Mais aussi Nightcafe Studio, Photosonic, Artbreeder … énièmes outils de génération d’images « ‘artistiques ».

J’attire également votre attention sur le travail tout autant remarquable de Geoffrey Dorne et notamment l’article autour de son projet d’illustrations de dépêches AFP à partir de générateurs d’IA.

Et comme je navigue depuis 2 mois dans ces étranges créations, en plus des travaux et du talent de Geoffrey Dorne et d’Etienne Mineur, je partage ici quelques autres découvertes, comme ce prompt « GoPro Footage » ajouté à des grands moments de l’histoire et qui donne de saisissants résultats, et l’incontournable Weird Dall-e mini generations qui est vraiment … Weird.

One More Thing.

Il faut enfin noter qu’après la génération d’images « artistiques » (ou pas), c’est la génération de vidéos qui s’affiche comme le prochain tournant majeur des processus créatifs génératifs. Et qu’en la matière on dispose là aussi de quelques outils et expérimentations déjà tout à fait sidérants qui posent exactement les mêmes questions que celles décrites dans l’article que vous venez de lire, mais à l’échelle de l’image animée et de la place peut-être encore plus centrale qu’elle occupe notamment dans les heuristiques de preuve contemporaines. On citera notamment, de la société Replicate l’outil « deforum » qui permet d’animer des prompts à partir de la base Stable Diffusion. Mais Méta (Facebook) et Google (Alphabet) viennent aussi de se lancer dans la génération automatique de vidéos. Pour Google cela se passe autour du projet Imagen Vidéo, et pour Facebook c’est l’outil « Make a video » qui est détaillé ici. Et Apple de son côté a aussi lancé Gaudi, un outil du même calibre.

A propos de Make a Video, Mark Zuckerberg déclarait :

On l’appelle Make-A-Video. Vous lui donnez une description textuelle et il crée une vidéo pour vous.

Nous lui avons donné des descriptions comme : « un ours en peluche qui peint un autoportrait », « un bébé paresseux avec un bonnet tricoté qui essaie de comprendre un ordinateur portable », « un vaisseau spatial qui atterrit sur Mars », et « un robot qui surfe sur une vague dans l’océan ».

C’est un progrès assez étonnant. Il est beaucoup plus difficile de générer des vidéos que des photos, car en plus de générer correctement chaque pixel, le système doit également prédire comment ils vont évoluer dans le temps. Make-A-Video résout ce problème en ajoutant une couche d’apprentissage non supervisé qui permet au système de comprendre le mouvement dans le monde physique et de l’appliquer à la génération traditionnelle de texte en image.

Bravo pour cet excellent et passionnant papier (numérique).

Bonjour,

Merci pour cet article !

Pour info, voici quelques typos repérées en le lisant :

– les “dialogues” qui nous avons (qui -> que)

– Aprè!s l’Outpainting (supprimer le !)

– par exemple en trouvent (trouvent -> trouvant)

merci de votre relecture attentive, c’est corrigé 🙂

Bonjour

Pas la peine de publier ce commentaire.

Bravo et merci.

Mais ça fait plusieurs années que vous n aviez pas eu d articles si bien avec plein de références pertinentes et bien écrit. ( c est a dire sans vulgarités en particulier qui m empêchaient par exemple de faire suivre l article à mes enfants par exemple).

Ça doit être un effet que la crise Covid serait derrière maintenant car les articles de fouloir sur les étudiants / gestion de Covid étaient peut être bien sur le fond mais sur la forme non. J’ai bien fait d attendre jusqu a aujourdhui. Bon voilà c était juste un mot d encouragement à continuer sur ce ton pour ma part en tout cas. 🙌🏻 et 🙏🏾

Euh …

Certain(e)s ont semble t-il apprécié mais, pour moi qui n’acceptais les « pavés » précédents que parce qu’ils étaient très majoritairement intéressants, le nouveau format m’aura rendu ce dernier article farouchement indigeste.

La forme donc plus que le fond (j’ai interrompu ma lecture) et je pense avoir eu tort, il n’empeche.

Article impressionnant, qui va mériter plus d’une relecture tant les sujets liés mènent vers moults pistes de réflexion. Pour avoir taquiné une application IA sous Android (Dream) afin de générer des images avec différents styles artistiques, j’avoue avoir été vite frustrée par l’interprétation des mots intégrés et ne pas retrouver ce que la création humaine permet (harmonie, composition, liberté de création et imaginaire). Je saisis mieux avec votre article la complexité des algorithmes et les limites imposées à ce type d’application. Vous avez poussé les tests plus loin (avec des citations et phrases) et les questions des mots tabous, du droit et du risque de mauvaise interprétation / confusion entre images originales + celles générées par les IA interrogent.