Pour archivage et partage, je republie ici une version (légèrement plus longue et agrémentée de liens) de la tribune parue dans le journal Le Monde du Samedi 7 Octobre 2023 sous le titre « Intelligence artificielle : nous sommes passés du rêve d’un web sémantique à la réalité d’un web synthétique.«

______________________________________________

Un peu plus de 10 après avoir inventé le web, Tim Berners Lee signait en 2001 avec deux autres collègues un texte qui posait les bases de son futur : le web sémantique. Il s’agissait de renforcer la structuration et la description du code des pages web pour permettre à des programmes informatique (des « agents », des « bots ») d’opérer un certain nombre de services à la manière d’un assistant personnel : prise de rendez-vous, calculs de trajets, vérification croisée d’informations, transactions commerciales, démarches administratives, etc. Dans l’esprit de Tim Berners-Lee et en l’état des technologies de l’époque, il s’agissait dans un premier de rendre la recherche d’information sur le web plus efficace en automatisant certains de ses aspects (en 2001 le moteur Google n’avait que 3 ans et n’occupait pas encore la place centrale qui est la sienne aujourd’hui) et dans un deuxième temps de déployer des services (par le biais de ces agents) qui pourraient aussi communiquer entre eux grâce à la structuration renforcée du code derrière les pages web ainsi qu’à la mise en oeuvre d’ontologies, des sortes de super thesaurus permettant d’établir des équivalences sémantiques partagées entre des pages web différentes. Après avoir permis à l’humanité connectée de se parler et de s’écrire sans entraves avec l’invention du World Wide Web en 1989, le web sémantique poursuivait l’objectif que les « machines » puissent se parler entre elles. Tim Berners-Lee précisait cependant : « le web sémantique permettra aux machines de comprendre les documents et les données sémantiques mais pas la parole et les écrits humains. »

Quelques vingt années plus tard, le monde entier fut bluffé par l’arrivée d’un agent conversationnel inédit pour le grand public, capable de mimer l’apparence de raisonnements et de le faire dans le dialogue, et semblant cette fois parfaitement capable de comprendre non seulement les documents mais aussi la parole et les écrits humains : ChatGPT reléguait du même coup en quelques jours Siri, Alexa et autres « OK Google » à une sorte de préhistoire triviale.

Il y a quelques semaines et selon une indiscrétion du Financial Times, on apprenait que Mark Zuckerberg envisageait prochainement le lancement d’agents (bots) dopés à l’intelligence artificielle et dotés de « personnalités » (sic) qui agiraient « comme des assistants, des coachs ou qui peuvent vous aider à interagir avec des entreprises et des créateurs », ajoutant aussi « Nous ne pensons pas qu’il y aura une seule IA avec laquelle les gens interagiront. » Cette gamme vient d’être lancée le 27 Septembre 2023.

De fait, pendant ces vingt dernières années, c’est presque la moitié du trafic sur le web qui est généré uniquement par des bots, lesquels bots sont aussi présents en masse dans les différents médias sociaux.

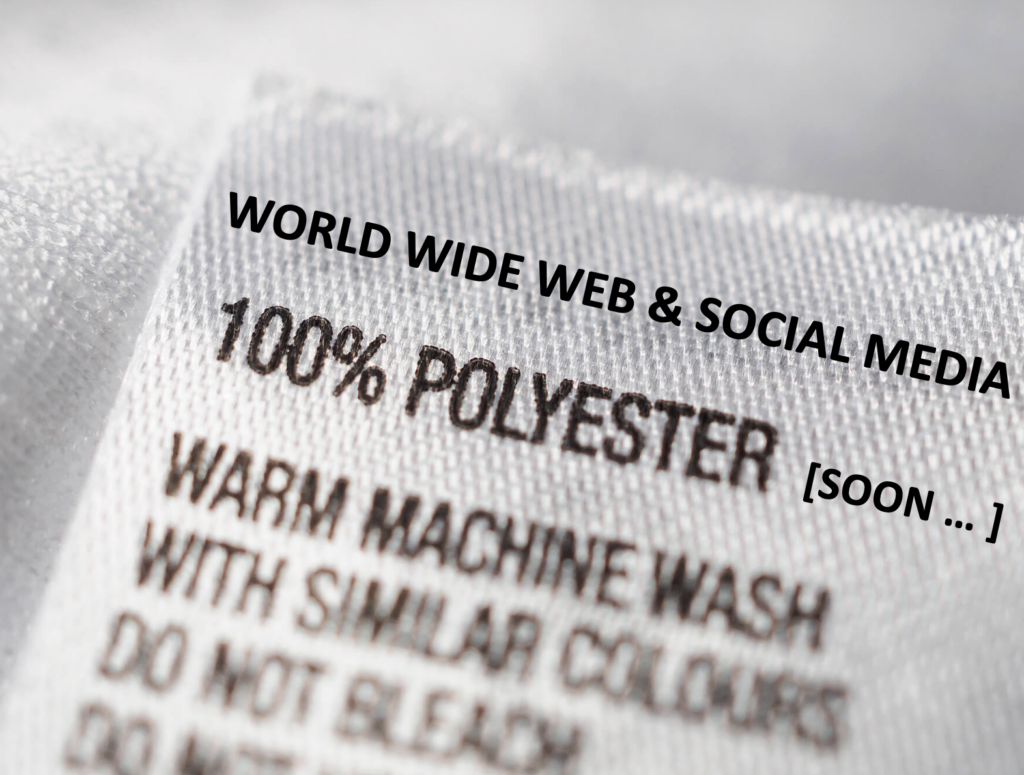

En 20 ans nous sommes passés du rêve de Tim Bernes-Lee d’un web sémantique, à la réalité d’un web presqu’essentiellement … synthétique. La sémantique et les ontologies n’ont bien sûr pas disparu et comptent toujours beaucoup dans l’élaboration des méthodes dites « d’apprentissage profond » (Deep Learning) qui sont l’un des piliers de l’intelligence artificielle. Mais le web, celui des plateformes notamment, dans sa part visible comme invisible, semble avoir changé de nature.

C’est un web synthétique parce qu’il n’est plus grand chose de « naturel » à la fois dans les interactions mais aussi dans les informations qui y circulent. Entre l’espace public du web et les espaces semi-publics des plateformes, on trouve partout et en masse des Bots, des agents conversationnels, des algorithmes de contrôle assumant des effets d’éditorialisation que leurs propriétaires n’essaient même plus de dissimuler ou de nier.

Si les études scientifiques et techniques convergent pour signaler que presque la moitié du trafic de l’internet mondial est désormais assuré par des bots, on observe également que la part des bots dans la production d’informations (vraies ou fausses) et dans les interactions en ligne au sein des plateformes est de plus en plus importante et nous conduit vers ce qui pourrait rapidement devenir une hémiplégie non seulement navigationnelle, mais aussi informationnelle et interactionnelle. Un web dans lequel nous naviguerions, discuterions et interagirions au moins autant avec des programmes informatiques qu’avec des individus. A l’échelle des plateformes de médias sociaux il est extrêmement difficile d’estimer la part réelle de ces bots puisque la recherche publique indépendante ne peut avoir accès à ces données. Mais rien qu’à l’échelle de Twitter, la question du nombre de bots par rapport au nombre réel d’utilisateurs constitua l’un des épisodes mouvementés de son rachat par Elon Musk. Et si Twitter (désormais X) affirmait à l’époque que seul 5% des comptes étaient des robots, différentes études font état d’estimations allant de 20 à 80% des comptes actifs de la plateforme.

C’est un web synthétique également car dans l’ombre d’usines de l’autre bout du monde, à Madagascar, aux Philippines, au Kenya, se trouvent des travailleurs et des travailleuses qui à l’instar de l’industrie textile, oeuvrent dans des conditions misérables pour que nous jouissions de toujours plus de contenus « modérés » pour nous éviter le pire, et pour que les agents conversationnels soient de mieux en mieux « contrôlés » à l’opposé du grand récit solutionniste qui voudrait nous faire croire que « l’intelligence artificielle » serait une forme de transcendance qui n’aurait besoin d’aucune intervention ou régulation humaine. Des travailleurs et travailleuses toujours plus invisibles, mais à la charge de travail toujours plus pénible et dense, et qui génèrent toujours davantage de contenus artificiels.

C’est un web synthétique parce que l’essentiel de ce qui y est discuté comme de ce qui y est vu, est produit par la synthèse d’algorithmes artificiels et « d’agents » (bots) tout autant artificiels, les premiers et les seconds convergents au service d’intelligences artificielles opaques et qui malgré leur apparence de rationalité ne sont rien d’autre que des perroquets stochastiques opérant le plus souvent au service d’intérêts économiques.

C’est un web synthétique enfin parce qu’il est l’objet, sous nos yeux, d’une nouvelle inflation autant que d’une nouvelle inertie : l’ensemble des contenus produits ou organisés par les bots et les algorithmes permet de produire d’autres contenus et d’autres bots qui eux-mêmes viennent nourrir d’immenses jeux de données utilisés par des technologies de Deep Learning et d’intelligence artificielle pour produire … toujours plus de contenus artificiels ou artificialisés qui à leur tour … et ainsi de suite ad libitum.

Le projet des grands capitaines d’industrie de la Tech, de Zuckerberg à Musk, n’est plus de permettre à l’humanité de se parler ni même de nous permettre de dialoguer avec des robots, mais de permettre à des robots de nous parler pour nous indiquer quoi faire, que dire et où regarder. Et face à cela, les environnements numériques dans lesquels nous passons le plus de temps sont tellement contraints, que nos tentatives pour que nos interactions, nos navigations, nos discussions et nos dialogues se tiennent à des logiques les plus « naturelles » possibles ressemblent de plus en plus au supplice d’un Sisyphe. Ils ont en tout cas un coût cognitif bien trop lourd au regard de l’utilisation quotidienne que nous en avons.

L’histoire du web nous enseigne heureusement que rien n’est jamais certain hormis les tentatives d’appropriation marchandes de toute forme d’échange et d’interaction en ligne. La seule urgence aujourd’hui, par delà celle de ce constat, est de s’attacher sans relâche à documenter la manière dont l’artificialité gagne ce média qui fut un temps l’un de nos biens communs les plus précieux et qui peut et doit continuer de l’être.

Et si « l’intelligence artificielle » est aujourd’hui partout, il faut aller au bout de la métaphore de l’artificialisation et se se rappeler ce qu’elle produit à l’échelle des sols ou des milieux naturels quand elle est mise en oeuvre : elle les épuise, elle diminue leur capacité de résilience et elle réduit leur biodiversité. Le web est certes un environnement technique fait de protocoles, de serveurs, d’algorithmes et d’immenses jeux de données ; mais il est aussi et avant tout un écosystème social, informationnel, affectif et cognitif. Tim Berners-Lee le rappelait dès 1999 dans son ouvrage « Weaving The Web » :

The web is more a social creation than a technical one. I designed it for a social effect — to help people work together — and not as a technical toy. The ultimate goal of the Web is to support and improve our weblike existence in the world. We clump into families, associations, and companies. We develop trust across the miles and distrust around the corner.

Et l’on observe déjà depuis plusieurs années qu’il est de moins en moins résilient aux attaques, et que la diversité des interactions et des contenus se restreint y compris quand son nombre d’utilisateurs augmente. La préservation du web en tant que milieu naturel plutôt que synthétique, passe par la prise de conscience de ce que les processus d’artificialisation en cours altèrent de sa nature profonde et par notre capacité commune à en combattre les effets délétères aujourd’hui les plus saillants. À commencer par les récits idiots d’entrepreneurs qui entre deux concours de masculinité toxique, nous annoncent toujours plus de bruits de « bots », mais de bots dotés de « personnalités ».

Un jour probablement pas très lointain, on utilisera un moteur de recherche basé uniquement sur archive.org bloqué sur < 2023 afin d'avoir des résultats de recherche uniquement non synthétiques. Ceux d'avant l'ère de l'IA.