Jusqu’à la nausée nos espaces médiatiques vont être saturés d’échos de ces deux jours où la France accueille le sommet mondial de l’IA. Avec quelques signaux faibles intéressants : le contre-sommet de l’IA lancé simultanément par le philosophe Eric Sadin, et des initiatives fédérées comme celle de « Hiatus » qui réunit des acteurs du libre et des militants des libertés numériques. Et puis Mardi soir la diffusion du documentaire « Les sacrifiés de l’IA » de Henri Poulain sur France 2 (avec Antonio Casilli à la manoeuvre en conseiller scientifique).

Et Macron qui fait le con.

Alors voilà, un sommet de l’IA poussé par le président de la Start-Up nation qui s’est vautrée et qui tente d’être le président de l’IA nation qui va se lever. Et qui se fend d’un post totalement lunaire sur son compte X, dans lequel il met en scène des Deep Fakes de sa propre image et de sa propre voix pour dire d’abord « Bien joué » (sic) et expliquer que ça l’a même fait rire, puis pour rappeler « l’importance de ce sommet de l’IA » (dans lequel on ne va donc pas faire que golri), avant de rediffuser un Deep Fake de lui en MacGyver et de conclure « Ok, là c’est bien moi« .

« Bien joué »

Et là bon bah comment te dire Manu. Mettre en scène ses propres Deep Fake dans un message qui semble valider l’importance d’être en alerte sur ces technologies de propagande mais en les présentant comme essentiellement comiques (« ça m’a fait rire« ) et en se présentant comme battu (« bien joué« ), puis conclure en validant la performativité d’un mensonge (« Ok là c’est bien moi« ), le tout depuis son compte officiel à 10 millions d’abonnés, non seulement ça invalide totalement le très court passage du milieu (20 secondes sur les 55 secondes du post) sur « venez au sommet de l’IA c’est important et ça va changer la santé, l’énergie, la vie (…) », et accessoirement ça éparpille façon puzzle le travail patient de l’ensemble du monde académique, scolaire et universitaire, et d’une partie du monde médiatique, qui s’échine à démontrer l’urgence de réfléchir à de nouvelles heuristiques de preuve.

La dernière fois qu’il était apparu sur un média social c’était sur TikTok et pour rétablir le glaive de la justice sur un sujet Ô combien régalien (non) en réaction à un influenceur qui se plaignait d’avoir reçu une amende pour avoir réglé au péage avec son téléphone. Et là pour annoncer son sommet de l’IA et alors que l’ensemble de la chaîne de valeur informationnelle (et donc culturelle) est en train d’être éparpillée façon puzzle par ces artefacts génératifs et les puissances qui les possèdent et les manipulent, le type se fend d’un post en mode « c’est quand même bien rigolo tout ça ». On a juste envie de lui dire « Chaton, sois gentil, ouvre un Whatsapp avec ta famille, et fais-toi plaisir pour y partager tes délires kikoulol mais bordel de merde lâche la rampe des espaces publics dans lesquels tu touches 10 millions de personnes en tant que président de la république. »

Dans un siècle ou deux les historiens qui se pencheront sur notre époque auront toujours du mal à comprendre comment le président d’un BDE d’école de commerce a pu par deux fois être élu à la présidence de la république rien qu’en filmant ses oraux aux épreuves du cours de Marketing de 1ère année de l’ESSEC.

Revenons à ce sommet de l’IA.

Un sommet dans lequel les acteurs du domaine vont faire des annonces (Truc.AI va sortit un tout nouveau modèle encore plus powerful et green, Machin.AI va lancer un giga centre de données à Trifouillis les Oies, Bidule.AI va révolutionner le secteur des services de telle ou telle niche de consommation). Un sommet dans lequel les politiques vont faire des annonces (Machin va annoncer un « grand plan de l’IA », Truc va décrire comment dans toutes les administrations on va faire de l’IA et même que ça va tout disrupter, Bidule va rappeler que quand même ici c’est la France et pas le Far-West et que la French Rectal Touch va conserver ses valeurs sauf si vraiment on la regarde avec des doigts emplis de vaseline). Le tout va se terminer par quelques plus ou moins gros contrats, une pluie d’argent magique, une foule de communiqués de presse oscillant entre le laxatif et le laudatif, l’annonce d’un grand plan de formation (préempté par des acteurs essentiellement privés des « EdTech ») et bien sûr une charte (qui ne sera pas respectée), un calendrier (qui ne sera pas tenu), et une feuille de route pensée comme un argument auto-suffisant pour éviter les sorties de route. On va bien sûr parler de l’impact écologique de ces technologies en expliquant qu’on fait confiance aux acteurs de ces technologies pour réduire leur impact écologique (donc en vrai on ne va pas parler d’écologie). Et pour le reste et les questions (notamment) liées aux problématiques de surveillance, la dernière enquête de Disclose atteste de l’Open Bar validé par Matignon en lien avec l’Elysée dans le cadre de l’IA Act. Voilà. Ce passage a été écrit samedi 9 février (la preuve) et vous voyez déjà ce mardi 11 Février qu’à peu près l’ensemble de ce qui y est décrit est advenu. Magie 🙂

Le canard de Vaucanson.

Dans l’histoire des techniques de l’automatisation il est au moins deux grands exemples qui ont toujours valeur d’analogie. Le premier de ces exemples est relativement connu et je vous en ai déjà souvent parlé ici, il s’agit du Turc mécanique (1770), cet automate supposé jouer aux échecs alors qu’en fait bah non il y avait quelqu’un de caché à l’intérieur. Amazon reprit d’ailleurs avec son habituel cynisme cette histoire pour en faire « Amazon mechanical Turk« , l’une des premières plateformes numérique d’exploitation des travailleurs pauvres de la galaxie connue (mais eux ils parlent de « crowdsourcing »). Le symptôme ou syndrome du Turc mécanique est devenu une sorte de constante des grands messes technologiques (dernier épisode en date, les robots humanoïdes autonomes de Musk, mais on pourrait aussi mentionner la vidéo bidonnée du lancement de l’IA Gemini chez Google et plein d’autres) tout autant qu’un puissant facteur d’explication et d’explicitation des mécanismes de dissimulation et d’exploitation qui traversent la sociologie du numérique (et dont l’un des points culminants est l’ouvrage « En attendant les robots » d’Antonio Casilli).

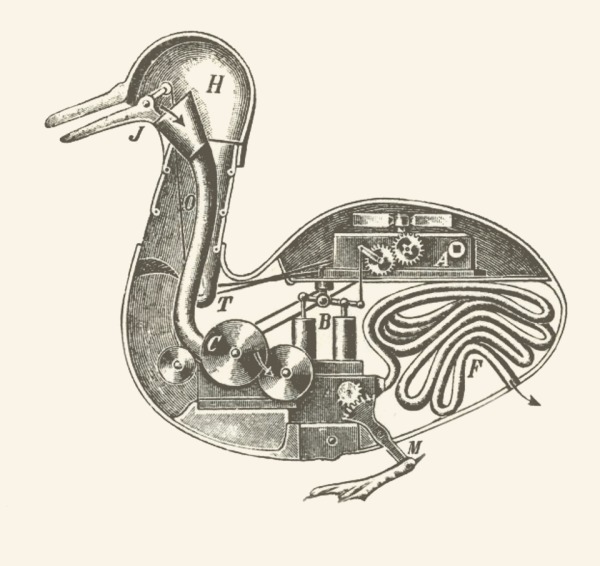

Et l’autre grand exemple, un peu moins connu du grand public me semble-t-il, c’est le canard de Vaucanson, également connu sous le nom de canard défécateur.

(Source BNF)

Précédant de quelques dizaines d’années le Turc mécanique, ce canard automate est présenté au public aux alentours de 1739 et il sera décrit ainsi dans l’encyclopédie de Diderot et d’Alembert :

» Il boit, barbote dans l’eau, croasse (sic) comme le canard naturel […], il allonge son cou pour aller prendre du grain dans la main, il l’avale, le digère, et le rend par les voies ordinaires tout digéré ; tous les gestes d’un canard qui avale avec précipitation, et qui redouble de vitesse dans le mouvement de son gosier, pour faire passer son manger jusque dans l’estomac, y sont copiés d’après nature : l’aliment y est digéré comme dans les vrais animaux, par dissolution, et non par trituration ; la matière digérée dans l’estomac est conduite par des tuyaux, comme dans l’animal par ses boyaux, jusqu’à l’anus, où il y a un sphincter qui en permet la sortie. »

Un canard automate qui fait caca. L’allitération est belle, la métaphore l’est également. Et un canard automate qui digère « par dissolution et non par trituration. » C’est à dire qui reproduit non pas mécaniquement mais chimiquement le processus de digestion, afin d’être au plus près (en tout cas pour l’époque) des connaissances biologiques sur ce sujet.

Prenez maintenant les deux, le canard défécateur et le Turc mécanique, et vous avez un spectre presque complet des questions soulevées par cet ensemble de technologies : automatisation, imitation, dissimulation, reproduction. Un ensemble de technologies (« l’intelligence artificielle ») qui singent aujourd’hui la réflexion à peu près dans les mêmes proportions et avec la même vraisemblance que le canard de Vaucanson singeait la digestion, et qui surtout, dans la version grand public qui constitue aujourd’hui l’essentiel de leur dynamique, nous noient littéralement sous des flots de merde (voir à ce sujet les travaux de Cory Doctorrow sur l’emmerdification – enshittification – ou plus immodestement les miens sur l’avènement d’un web synthétique).

Et écrire cela n’est pas nier l’immensité des progrès et des promesses de ces technologies dans des secteurs comme celui de la santé (médecine, biologie, etc.) mais simplement rappeler qu’elles sont aujourd’hui essentiellement opérantes comme autant de technologies de gestion (management) au service d’intérêts économiques capitalistiques et principalement spéculatifs visant à optimiser des rentes existantes ou à en créer de nouvelles. Je vous invite d’ailleurs à lire le remarquable ouvrage de Pablo Jensen, « Deep Earnings », pour comprendre le lien épistémologique très fort entre l’invention du néolibéralisme et celle des réseaux de neurones. Si le sommet de l’IA se résumait à la lecture publique de cet ouvrage, alors au moins aurait-il servi à autre chose qu’à un immense satisfecit.

[Incise] Il faut toujours penser « l’iA » avec un pas de côté. Par exemple à la très présente et très pénible bullshit question du « grand remplacement par l’IA » qui peuple n’importe quel sujet journalistique grand public (« Mais quels métiers l’IA va-t-elle remplacer ? » et de lister tout à trac les radiologues, les secrétaires, les avocats, les institutrices, puéricultrices, administratrices, dessinatrices, les boulangers, les camionneurs, les policiers, les agriculteurs, les ménagères, les infirmières, les conseillères d’orientation, etc.), posons-nous plutôt la question, simple, de savoir qui veut, ou qui a intérêt à remplacer les radiologues, les secrétaires, les avocats, les institutrices, puéricultrices, administratrices, dessinatrices, les boulangers, les camionneurs, les policiers, les agriculteurs, les ménagères, les infirmières, les conseillères d’orientation, etc. Et vous verrez que bizarrement les enjeux nous apparaîtront beaucoup plus clairement. [/incise]

On a surtout besoin d’un sommet épistémologique.

Pour comprendre, toujours de manière fine, ce qui est à l’oeuvre derrière ces sommets et annonces autour de l’intelligence artificielle (en France mais partout dans le monde), je vous invite très vivement à lire cet article là encore remarquable (et remarquablement synthétique) de Jacques Haiech, disponible en accès ouvert : « Parcourir l’histoire de l’intelligence artificielle, pour mieux la définir et la comprendre. » Je vous en livre quelques extraits.

[les conférences Macy] ont permis d’acter une fracture entre deux communautés : celle qui veut simuler les processus cognitifs, en utilisant des machines digitales, et celle qui veut comprendre ces processus, en prenant en compte les caractéristiques émotionnelles et sociales. Jean-Pierre Dupuy (ingénieur et philosophe français) a analysé le rôle de ces conférences dans la naissance des sciences cognitives. (…)

Le terme « Intelligence artificielle » a été choisi en juillet 1956 par John McCarthy, pour ne pas faire allégeance à la « cybernétique » et à son chef de file, Norbert Wiener. Ce dernier va se rapprocher du « ratio club », un club anglais fondé par John Bates, qui réunira ses membres de 1949 à 1958, et où l’on trouve Ross Ashby (psychiatre-ingénieur anglais venu très tôt à la cybernétique) et, après la première réunion, Alan Turing. Un nouveau domaine de recherche ayant pour objet la simulation et la compréhension des processus cognitifs est, à cette époque, en train de naître. On assiste alors à une bataille sémantique, porté par les ego de chacun, et la création de deux communautés distinctes (l’intelligence artificielle qui a ses racines plutôt américaines et la cybernétique/systémique qui a plutôt ses racines en Europe). Ces deux communautés sont cependant en interaction permanente, mais avec des niveaux de financements qui varient dans le temps. Pour l’intelligence artificielle, on parlera d’une succession de périodes hivernales (hivers de l’IA), dans les moments où elle ne sera pas ou peu financée par les institutions aux États-Unis et en Europe.

La cybernétique, quant à elle, est un domaine qui est lié au concept d’homéostasie, cher à Claude Bernard (qu’il propose en 1865 dans son Introduction à l’étude de la médecine expérimentale) et que l’on va retrouver dans la théorie générale des systèmes de Ludwig von Bertanlanffy (en 1968). (…)

Dans les années 1960, on assiste à la convergence de quatre sous-domaines :

1. la cybernétique, avec son aspect robotique et automate (Norbert Wiener et John von Newman), qui est focalisée sur le rétrocontrôle (feedback) des structures vivantes (de la cellule jusqu’aux sociétés). Le vivant apparaît comme stable face aux agressions non programmables de l’environnement. On retrouvera ces paradigmes dans les travaux de Francisco Varella et de son mentor Umberto Maturana et, en France, ceux d’Henri Atlan (qui fut influencé par les travaux d’Heinz von Foerster, le rédacteur en chef des conférences de Macy) ;

2. la théorie générale des systèmes de Ludwig von Bertalanffy (influencé par les travaux de Ross Ashby, cité plus avant), qui sera à l’origine de la biologie des systèmes. Tout système vivant est constitué d’éléments qui interagissent entre eux et ce sont les différents modes d’interaction qui font émerger des comportements et des structures complexes. On y associe l’aphorisme selon lequel le Tout est supérieur fonctionnellement à la somme de ses éléments. On y perçoit aussi l’importance des flux d’information au-delà des flux de matière et d’énergie, et l’importance de l’émergence de la complexité par itération de lois simples : la fractalisation du vivant. Edgar Morin, lorsqu’il organise avec Jacques Monod et Massimo Piatelli-Palmarini le colloque de Royaumont en septembre 1972 sur l’unité de l’homme, va déboucher sur le concept de pensée complexe qu’il a emprunté à Ross Ashby ;

3. l’intelligence artificielle dans sa phase d’ingénierie qui, partant de l’analogie entre cerveau et ordinateur digital, va permettre de construire les machines, les langages et les modes de représentation de données, pour fabriquer des dispositifs capables de jouer mieux ou aussi bien qu’un être humain (théorie des jeux, recherche opérationnelle) ou de démontrer des théorèmes mieux ou aussi bien qu’un mathématicien (raisonnement symbolique) ;

4. les méthodes de classification, capables d’annoter des groupes d’objets à partir d’un langage de description prédéfini, ou capables de définir le meilleur langage de description, pour obtenir la meilleure annotation souhaitée. Dans le premier cas, on a affaire à une classification non supervisée et dans l’autre cas, à une classification supervisée. Les méthodes utilisées s’appuient sur les statistiques descriptives (avec les travaux de Jean-Pierre Benzecri, un mathématicien et statisticien français spécialiste de l’analyse de données), jusqu’aux réseaux neuronaux monocouches et multicouches, en pointe aujourd’hui avec les travaux de Yan LeCun sur le deep learning, en passant par les outils de statistiques peu enseignés, comme les inférences bayésiennes.

Ces différents sous-domaines ont induit la création de communautés avec leurs lots de jargons, de conférences et de journaux, et leurs leaders majeurs d’opinion. Peu ou pas de fertilisation croisée, et peu ou pas d’enseignements permettant d’avoir une vision globale et comparative de ces différentes positions et méthodes.

Et voilà. « L’intelligence artificielle » est riche de l’ensemble de cet héritage et de ces affrontements égotiques autant qu’épistémologiques et techniques. Et l’on ne comprend et ne comprendra rien aux enjeux de l’intelligence artificielle dans nos sociétés si l’on n’est pas capable de retrouver, de questionner et de mobiliser ces héritages et ces affiliations.

Et maintenant, les vaches rectangle 🙂

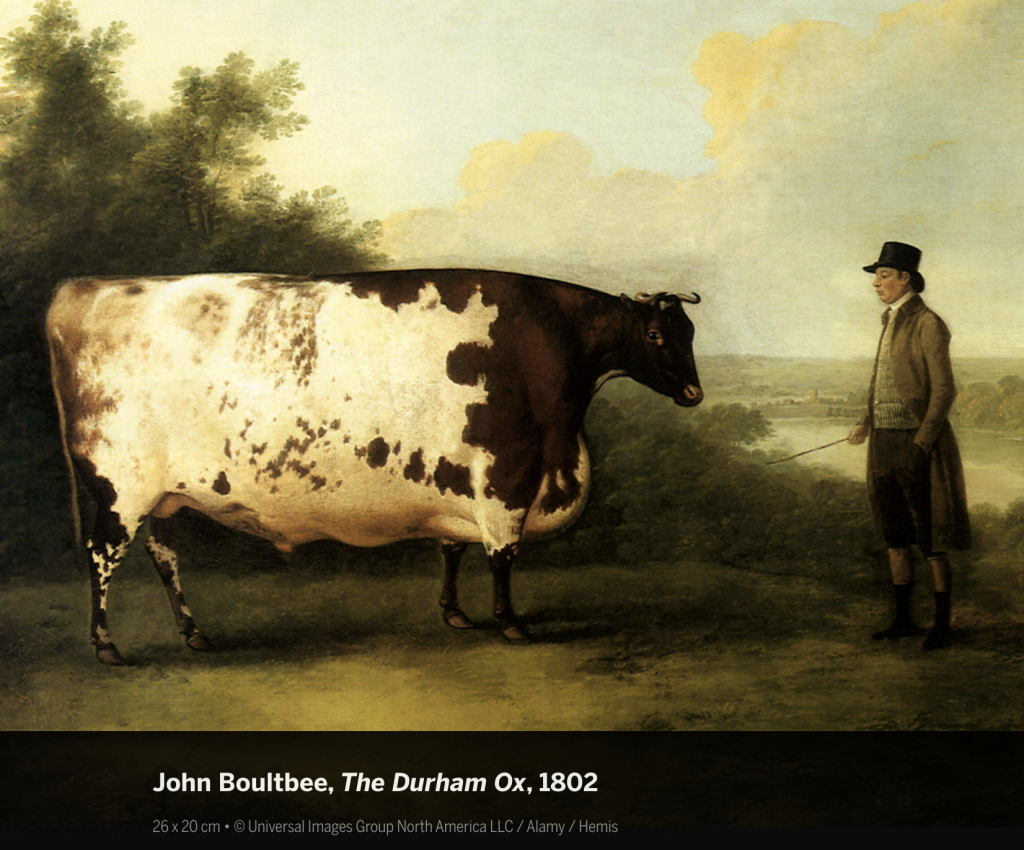

Le boeuf (ou taureau) de Durham (et les vaches rectangle).

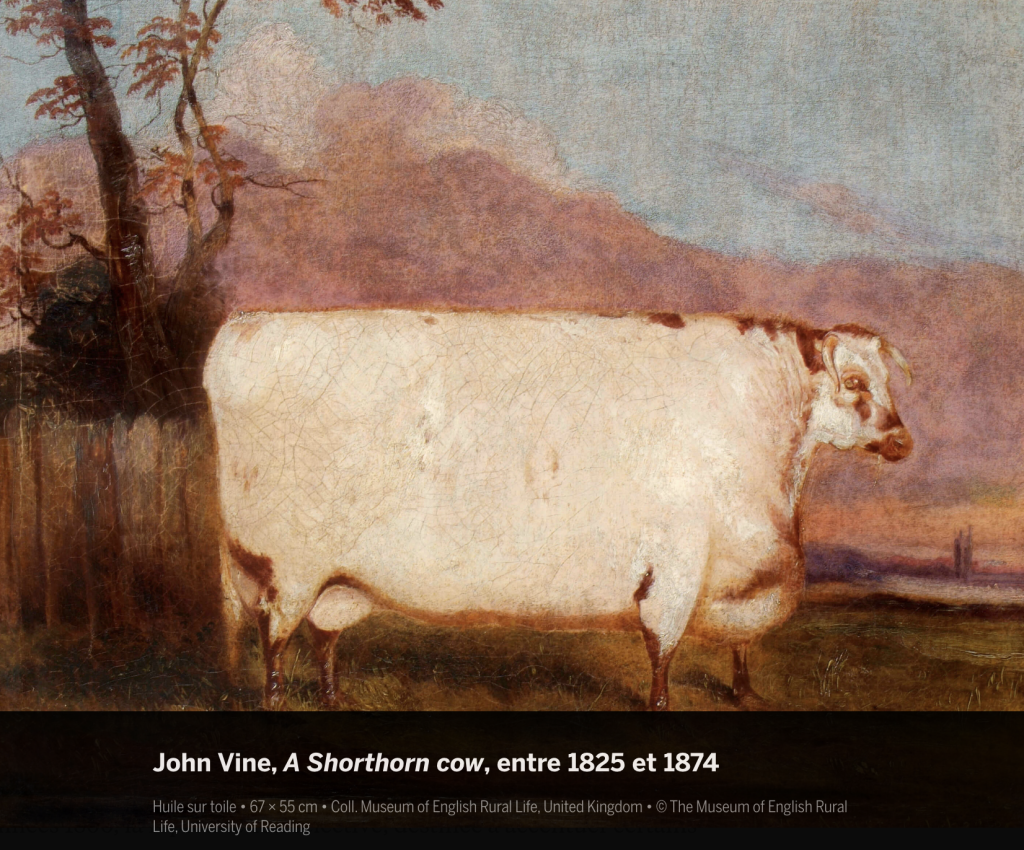

J’avoue être tombé là-dessus totalement par hasard et c’est une histoire dont je n’avais encore jamais entendu parler. Le boeuf (ou taureau) de Durham c’est donc ceci :

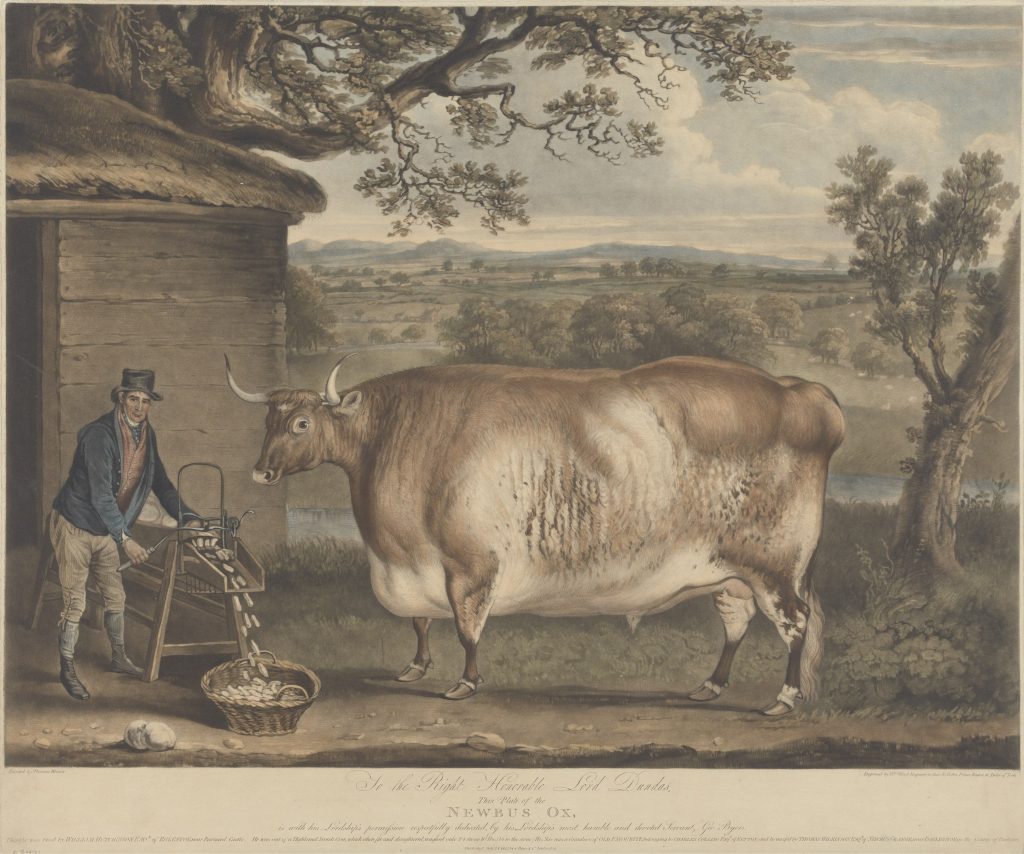

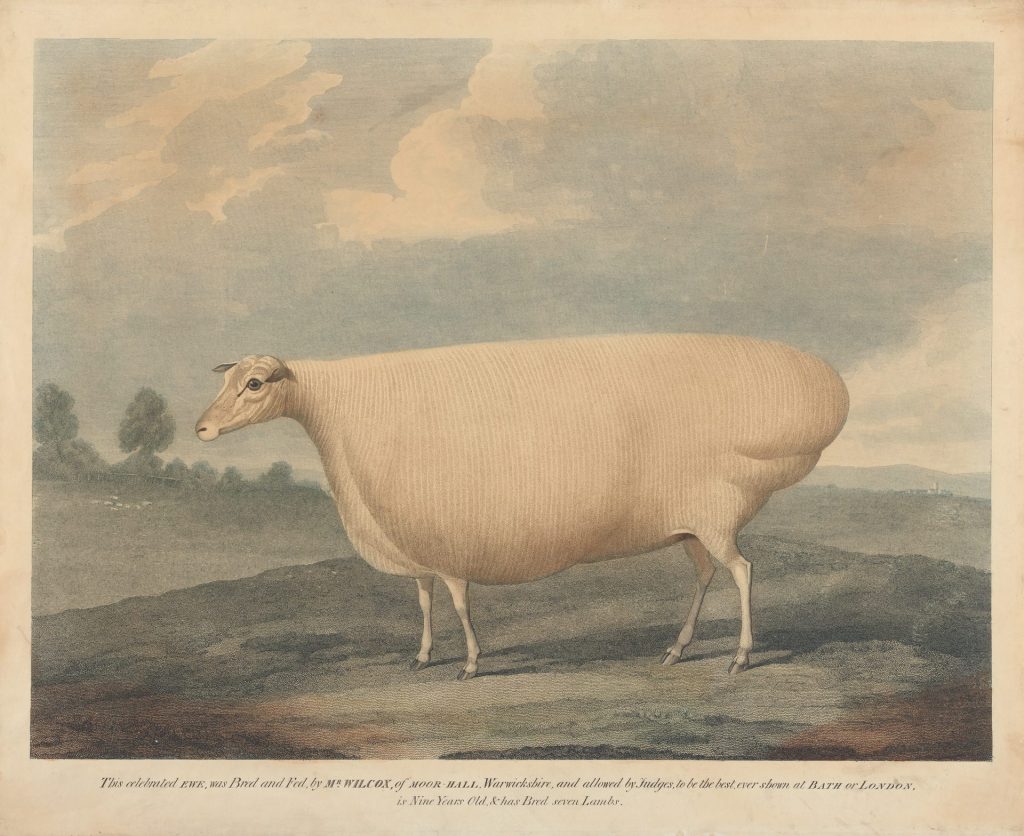

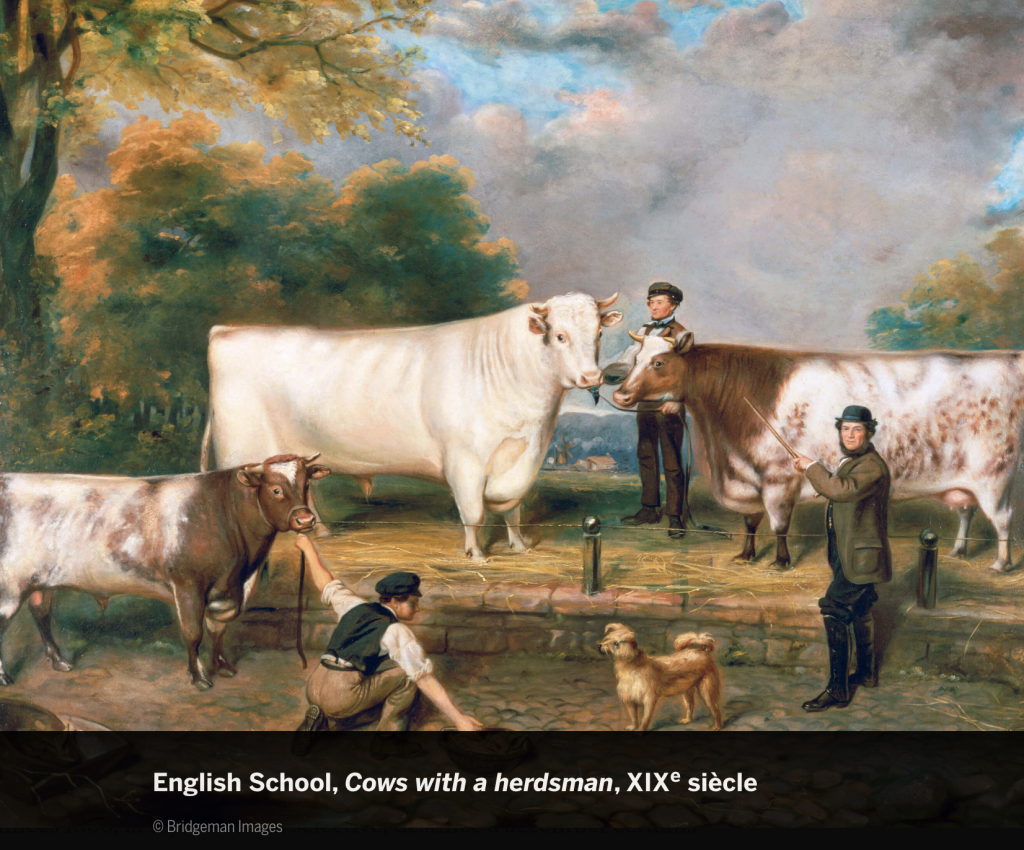

Et son histoire vous est (entre autres) racontée dans cet article et dans celui-ci, d’où je puise les illustrations suivantes, car oui le boeuf de Durham avait aussi plein de copains et de copines : les vaches rectangle et les moutons chelous. L’histoire donc d’un boeuf tellement gros et gras qu’il gagne un concours agricole, devient une légende, et finit par influencer tout une série de peintures et de représentations.

Et là je vous entends me dire : « Heu … mais c’est quoi le rapport avec l’IA ? ». Vous ne voyez pas ? Vraiment ? Dès que j’ai vu ces peintures à la fois voulues comme hyper-réalistes et naturalistes mais tout aussi délibérément irréalistes je me suis immédiatement souvenu de mes exercices de génération d’image via Midjourney ou d’autres artefacts génératifs (que je vous raconte dans ce remarquable livre ;-).

L’histoire de ce boeuf de Durham et des représentations animalières associées (ci-dessus mais il en existe plein d’autres), l’histoire de ces peintures du XIXème siècle, c’est celle de représentations étonnamment géométriques et exagérées que de riches propriétaires terriens commandaient pour se prévaloir de vendre et de posséder, à l’image du boeuf de Durham donc, des animaux « plus gros et plus gras que jamais » et s’afficher fièrement auprès d’eux. Qué lo apélorio : la peinture d’élevage.

« Le début du XIXe siècle a été l’apogée de la peinture d’animaux d’élevage. Les sujets étaient souvent des chevaux de course, peints en lignes fines dénotant leur vitesse et leur grâce. Mais pour les animaux de ferme, la corpulence était essentielle. Dans les peintures, la vache, le mouton et les cochons sont massifs, mais curieusement soutenus par seulement quatre pattes grêles. Parfois, leur propriétaire est également représenté, regardant fièrement leur création. D’autres fois, l’animal se tient seul, apparemment prêt à dévorer un village voisin. Ce style simple est souvent qualifié d’art rustique ou « naïf », même si les sujets étaient des animaux appartenant à une élite riche. Les images qui en résultaient étaient à la fois publicitaires et spectaculaires. » Anne Ewbank.

Et plus loin :

« L’historienne B. Litvo note également que les fermiers de la noblesse utilisaient le patriotisme pour justifier les compétitions et l’autopromotion. Si les élites pouvaient élever et nourrir des vaches plus grosses et plus grasses, les fermiers les plus pauvres pourraient éventuellement en être propriétaires. Avec plus de viande à vendre, les communautés rurales seraient plus stables financièrement. La sécurité nationale du pays en bénéficierait, selon l’argument avancé. La population britannique augmentait rapidement et, en raison de la perspective de guerres fréquentes, il était impératif de disposer d’un approvisionnement alimentaire sûr en animaux gras . L’« amélioration » progressa rapidement. Le poids moyen des vaches britanniques augmenta d’un tiers entre 1710 et 1795. (…)

« Les peintures et les gravures commerciales commandées étaient souvent accompagnées d’informations telles que les mensurations de l’animal et les efforts d’élevage du propriétaire. Selon le professeur d’études animales Ron Broglio, les portraits étaient souvent exagérés pour mettre en valeur la forme idéalisée de l’animal, qui consistait généralement à « [fournir] un peu plus de graisse dans les zones cruciales ». Pour les cochons, l’idéal était une forme de ballon de football américain. Les vaches étaient rectangulaires et les moutons avaient tendance à être oblongs. (…)

En plus de rendre célèbres les riches fermiers, les peintures et gravures animalières avaient une utilité pratique. Les éleveurs de tout le pays pouvaient utiliser l’image d’un animal spécifique comme modèle pour leur propre troupeau, car le bétail qui correspondait aux idéaux de beauté valait beaucoup plus cher. » Anne Ewbank.

Ce qui m’a frappé à la découverte de l’histoire du boeuf de Durham (et de ses copines les vaches rectangles et les moutons oblongs), c’est l’effet d’amorçage stéréotypique qui me semble par bien des points semblable à celui que nous observons aujourd’hui avec les artefacts génératifs dopés à l’IA. Ce qui nous est présenté par ces modèles, par ces « larges modèles de langage », ce sont aussi des vaches rectangle modernes. Des représentations de l’humanité qui insistent sur le « gras » d’une irréalité trouble jusqu’à distendre totalement notre perception de la réalité. Cette sorte d’inflation (je parlais dans un ancien article de capitalisme sémiotique) dans laquelle il s’agit avant tout, pour ces modèles et les sociétés qui les pilotent et les administrent de fabriquer des boeufs de Durham à la chaîne. De s’assurer de la dimension toujours consubstantiellement « publicitaire et spectaculaire » de la capacité même de génération et de ce qu’elle produit comme représentations.

Lorsque nous regardons aujourd’hui le boeuf de Durham et ses copines les vaches rectangle, nous comprenons ce pour quoi est faite cette représentation, les intérêts qu’elle sert et les ressorts bourgeois, capitalistes et ostentatoires qui la précèdent. Nous avons aujourd’hui une lecture politique de ces peintures, de ces représentations. C’est cette lecture politique qui nous a tant fait défaut lorsque, comme probablement quelques primo-spectateurs de ces peintures au XIXème siècle, nous fûmes et sommes encore confrontés aux mécaniques des artefacts génératifs de texte, d’image, de vidéo ou de toute autre chose. Nous peinons à en imposer une lecture politique alors que ces représentations ne servent que des intérêts économiques parfaitement délimités. Ce que parmi d’autres (mais bien mieux que d’autres) Kate Crawford soulignait dans son « Atlas de l’Intelligence Artificielle » :

L’IA n’est ni intelligente ni artificielle. Elle n’est qu’une industrie du calcul intensive et extractive qui sert les intérêts dominants. Une technologie de pouvoir qui à la fois reflète et produit les relations sociales et la compréhension du monde. (…) Les modèles permettant de comprendre et de tenir les systèmes responsables ont longtemps reposé sur des idéaux de transparence… (…) Dans le cas de l’IA, il n’y a pas de boîte noire unique à ouvrir, pas de secret à révéler, mais une multitude de systèmes de pouvoir entrelacés. La transparence totale est donc un objectif impossible à atteindre. Nous parviendrons à mieux comprendre le rôle de l’IA dans le monde en nous intéressant à ses architectures matérielles, à ses environnements contextuels et aux politiques qui la façonnent, et en retraçant la manière dont ils sont reliés.

(presque) Toute l’histoire contemporaine des artefacts génératifs et de l’intelligence artificielle est là dedans, mais également des questions de santé publique tournant autour de l’essor de formes neuves de dysmorphophobie à force d’usage de plateformes fabriquant ou jouant à dessein sur notre volonté de devenir des boeufs de Durham ou des vaches rectangle modernes (j’englobe ici la question de la sur-représentation de certains corps et de l’invisibilisation d’autres, mais aussi l’usage des différents filtres de TikTok à Snapchat en passant par Instagram, et bien entendu l’ensemble des relais médiatiques de ces perceptions « publicitaires et spectaculaires« . Il n’y pas grande différence entre les vaches rectangle, les moutons oblongs du XIXème siècle et les « hallucinations » visuelles encadrées de nos modèles contemporains d’IA au XXIème siècle.

« Les vaches grasses, les porcs massifs et les moutons obèses étaient prisés comme preuve de la réussite de leurs propriétaires dans la sélection des races en fonction de leur taille et de leur poids. Les fermiers nobles utilisaient la sélection sélective pour créer du bétail lourd et à croissance rapide. Parallèlement à la sélection, de nouvelles pratiques agricoles et alimentaires ont également produit des animaux plus gros. Les fermiers riches participaient à des concours agricoles et lisaient de nouvelles recherches. On les appelait « améliorateurs », car ils essayaient d’améliorer les races animales existantes. Des méthodes telles que nourrir les vaches avec des tourteaux et des navets pour un engraissement final avant l’abattage se sont généralisées. Même le prince Albert, époux de la reine Victoria, est devenu un améliorateur, en exhibant ses porcs et ses bovins primés. » Anne Ewbank.

Du canard défécateur de Vaucanson au boeuf de Durham et aux vaches rectangle, on croise énormément « d’améliorateurs » dans la grande galaxie néolibérale de l’IA (dont une bonne partie est représentée au sommet de l’IA). Toute métaphore a bien sûr ses limites interprétatives et il ne s’agit pas, heureusement, de littéralement nous mettre en situation d’être gavés par quelques riches fermiers investisseurs qui auraient pour seul horizon de produire des représentations suffisamment altérées de la réalité pour qu’elles satisfassent à leurs intérêts propres de publicitarisation et de spectacularisation. A moins que … attendez … Bon sang mais c’est bien sûr 😉

One More Thing.

Lorsque ces perceptions distendues de la réalité finissent par s’imposer comme d’authentiques formes de réalisable, alors nous entrons dans ce que Grégory Chatonsky nomme un espace latent et dans les logiques de « chiralité ».

« L’émergence des technologies d’intelligence artificielle a donné naissance à un concept fondamental qui transforme notre compréhension de la vérité : l’espace latent. Ce concept, qui mérite d’être défini avec précision, désigne un système mathématique complexe où les informations ne sont plus stockées sous forme de données discrètes (comme des fichiers constitués de 0 et de 1), mais comme des distributions statistiques continues. Plus concrètement, l’espace latent est une représentation multidimensionnelle où chaque dimension correspond à une caractéristique abstraite que l’intelligence artificielle a apprise à partir des données d’entraînement. (…) Or cet espace latent, fruit de la théorie des jeux et des espaces bayésiens où chacun parie sur le pari de l’autre transforme radicalement la relation entre discours, vérité et réalité. En effet, alors que la révolution industrielle avec introduit une reproductibilité technique des indices ou des traces de la réalité, telle que l’empreinte d’une lumière sur une surface photosensible, les espaces latents sont des expressions des indices passés. Ainsi, un espace latent peut non seulement reconnaître un oiseau qu’il n’a jamais vu, qui ne fait pas partie de sa base d’entraînement, s’il ressemble bien à un oiseau, mais il peut aussi générer un oiseau inexistant et crédible ouvrant le précipice du simulacre dans la réalité. (…) Un espace latent, pour produire un résultat crédible, doit être maintenu dans un savant et juste équilibre entre l’apprentissage et le bruit. D’un côté, il ne sait que reproduire le déjà appris, de l’autre il ne génère que de l’informe. Mais en ayant les deux, on peut créer du reconnaissable inexistant, bref automatiser et industrialiser la représentation mimétique. Nous dépassons non seulement l’empreinte du photoréalisme, mais encore la modélisation hypothético-déductive de la simulation informatique à laquelle nous ont habitués les effets spéciaux, la réalité virtuelle et les jeux vidéo. Cette conception de l’espace latent a des implications profondes sur notre compréhension de la réalité et de la vérité. »

Le concept d’espace latent est éclairant à plus d’un titre. Et la « chiralité » (en gros on objet ou un système qui n’est pas superposable à son image dans un miroir) l’est tout autant pour penser les logiques et les dynamiques de l’IA et de l’ensemble des évolutions numériques actuelles. Je vous en reparlerai probablement dans un autre article, mais d’ici là précipitez-vous pour lire celui de Grégory Chatonsky sur AOC.

Macron faisant le kéké avec ses deepfakes prouve non pas sa maîtrise du truc mais bien très amplement qu’il n’a rien compris à la problématique (et aussi qu’il n’en a rien à battre). L’autre aspect, c’est qu’il est président de la République française pas un quelconque youtubeur, la politique spectacle, si tant est que ça a un sens, doit avoir plus de hauteur. Tout ceci est assez inquiétant et consternant.

La question de l’IA est complexe, merci pour cet article.