Le 10 février 2025, France Info posait la question : « les IA conversationnelles comme ChatGPT sont-elles fiables ? »

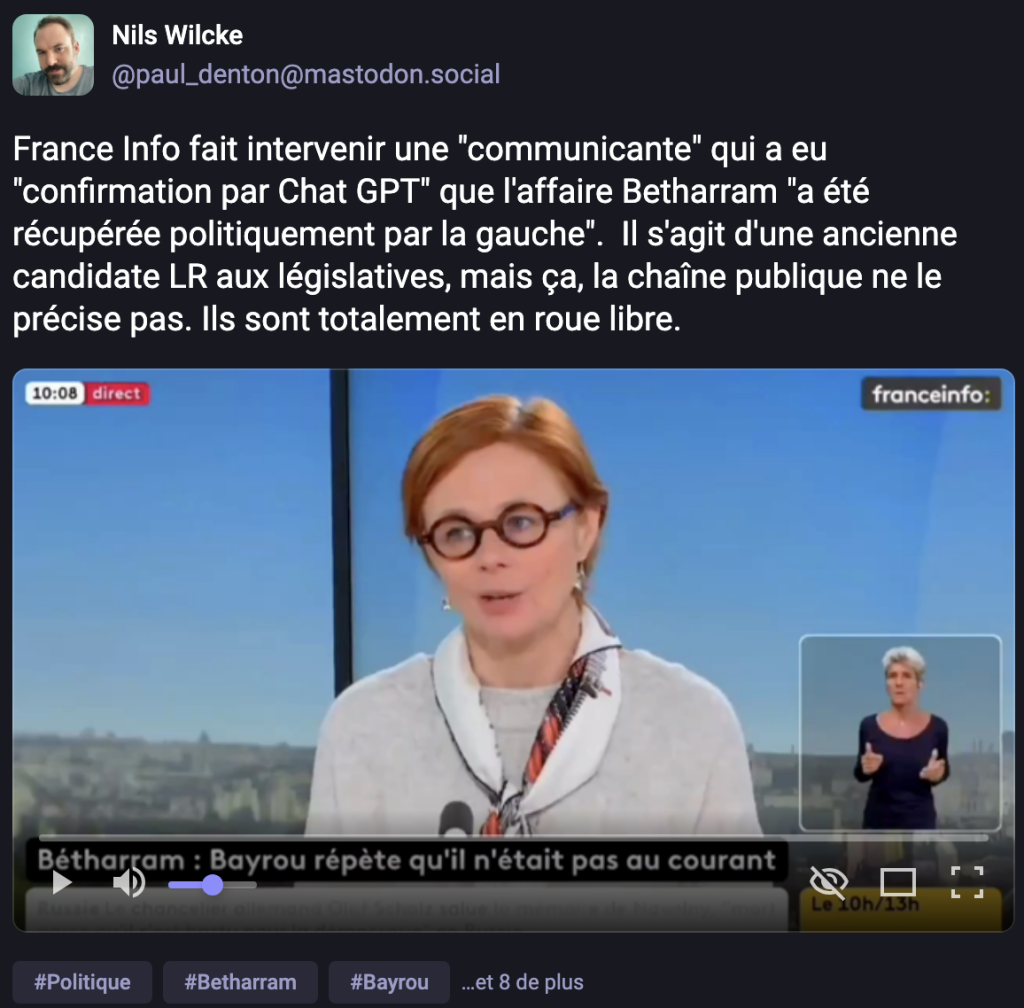

Le 16 février, dans une séquence dont le replay semble avoir été supprimé, France Info répondait à la question via une consultante en communication (ancienne candidate LR), qui lors d’un plateau au sujet de l’affaire Bétharram déclarait : « Même si vous demandez aujourd’hui à l’intelligence artificielle son avis sur le sujet, (…) même l’intelligence artificielle exprime qu’il y a une récupération et une instrumentalisation politique de l’affaire Bétharram. »

Ite, missa est. L’IA est donc fiable.

La séquence a été repérée et isolée par le journaliste politique Nils Wilcke depuis ses comptes X et Mastodon. Elle est depuis devenue relativement virale sur différents médias sociaux.

Le nom de la communicante importe peu, elle a depuis fermé son compte X, probablement (et malheureusement) victime de quelques trolls. Ce qui m’intéresse dans cette affaire, c’est le dispositif, le « cadre » informationnel, et ce « momentum » dans la courte histoire des artefacts génératifs grand public.

Le dispositif, le voici. Une chaîne d’information, un fait divers qui devient un fait politique, un.e consultant.e, un plateau de débat, en présence de journalistes. Et le recours à ChatGPT (qui n’est pas directement nommé dans la séquence mais qui est immédiatement convoqué dans l’esprit de toute personne la visionnant).

C’est à ma connaissance la première fois que sur une chaîne d’information, en présence de journalistes, à l’occasion d’un fait divers devenu fait politique, on explique et explicite que l’on peut donc, primo, « demander son avis (sic) » à ChatGPT, et deuxio, considérer que cet avis dispose d’une quelconque valeur de preuve.

Il semble ici important de rappeler deux points fondamentaux.

Primo, ChatGPT (ou n’importe quel autre artefact génératif) n’a pas d’avis. Il n’en a jamais eu et il n’en aura jamais. Ou alors, et plus exactement, s’il doit avoir un avis, c’est soit l’avis de celles et ceux qui le programment et lui dictent quoi dire (un désormais classique « perroquet stochastique« ), soit, et c’est mon deuxio, l’avis tendanciellement dominant dans les bases de données (y compris d’actualité) sur lesquelles il s’appuie pour produire des textes qui sont des agencements statistiques probables et intrinsèquement cohérents mais n’ont pas davantage de valeur de preuve ou de vérité que l’agencement de phrases statistiquement probables et intrinsèquement cohérentes d’une conversation de bistrot entre potes.

« L’avis » de ChatGPT c’est tout à la fois « l’avis » de l’air du temps et de celles et ceux dont les avis ont été les plus repris et en résonance dans les médias dont se nourrit (et que pille) ChatGPT.

Une expérience (scientifique cette fois) a récemment eu lieu dans laquelle on essayait non pas de connaître « l’avis » des générateurs de texte mais d’analyser de quel programme et de quel candidat politique ils étaient le plus proches et reflétaient le mieux les opinions, et donc de quelles « perspectives politiques » ils se faisaient les pourvoyeurs. Un article récent de Wired rend compte de ces travaux de Dan Hendrycks (directeur du Center for AI Safety) et de ses collègues (l’article scientifique complet est également disponible en ligne en version préprint) :

Hendrycks et ses collègues ont mesuré les perspectives politiques de plusieurs modèles d’IA de premier plan, notamment Grok de xAI, GPT-4o d’OpenAI et Llama 3.3 de Meta. Grâce à cette technique, ils ont pu comparer les valeurs des différents modèles aux programmes de certains hommes politiques, dont Donald Trump, Kamala Harris, Bernie Sanders et la représentante républicaine Marjorie Taylor Greene. Tous étaient beaucoup plus proches de l’ancien président Joe Biden que de n’importe lequel des autres politiciens.

Les chercheurs proposent une nouvelle façon de modifier le comportement d’un modèle en changeant ses fonctions d’utilité sous-jacentes au lieu d’imposer des garde-fous qui bloquent certains résultats. En utilisant cette approche, Hendrycks et ses coauteurs développent ce qu’ils appellent une « assemblée citoyenne« . Il s’agit de collecter des données de recensement américaines sur des questions politiques et d’utiliser les réponses pour modifier les valeurs d’un modèle LLM open-source. Le résultat est un modèle dont les valeurs sont systématiquement plus proches de celles de Trump que de celles de Biden. [Traduction via DeepL et moi-même]

D’où l’on retiendra donc que primo il est assez facile de « modifier » la perspective politique et donc ‘l’avis » de ces artefacts génératifs, et que deuxio les mêmes artefacts ont la tendance de n’exprimer que l’avis majoritaire sur lequel ils ont été entraînés et calibrés.

Donc je le répète une nouvelle fois, se servir de ChatGPT pour « avoir son avis » c’est comme se servir du premier résultat de Google sur la requête « migraine » ou « douleur abdominale » pour « énoncer un diagnostic médical« . Dans les deux cas, c’est l’équivalent de partir en plongée sous-marine avec un équipement de ski en pensant que tout va bien se passer au motif que sous l’eau comme en altitude, l’air se fait plus rare.

Je rappelle et souligne ce que j’écrivais encore récemment :

« Tant que ces modèles seront, de par leur conception même, en capacité même temporaire d’affirmer que les vaches et les moutons pondent des oeufs, et tant qu’ils ne seront capables que d’agir sur instruction et dans des contextes où ces instructions sont soit insondables soit intraçables, jamais je dis bien jamais nous ne devons les envisager comme des oeuvres de langage ou de conversation, mais comme des routines propagandistes par défaut, et délirantes par fonction.«

[By the way si cela vous intéresse, je vous rappelle que j’ai écrit en Juin dernier un livre entier sur le sujet. Les IA à l’assaut dy cyberespace que ça s’appelle.]

Cette séquence de France Info ou une consultante raconte avoir sollicité l’avis de ChatGPT et en fait part comme « simple » élément de preuve au beau milieu d’un parterre de journalistes qui semblent trouver cela « amusant » est un nouveau Bad Buzz pour France Info, après l’épisode déjà totalement lunaire et ahurissant de ce plateau où un expert du camping (ou de l’immobilier je ne sais plus) était invité pour « discuter » de la possibilité de faire en effet de Gaza une nouvelle Riviera. France Info qui par ailleurs dispose de journalistes, de rédactions et de formats tout à fait capables d’éclairer le débat public (mais qui vient d’écarter son directeur).

Mais cette dernière séquence fera date. Elle fera date car elle est le résultat de l’arsenal marketing déployé depuis déjà plus d’un an autour de ces assistants faussement conversationnels. Elle fera date car elle est l’aboutissement de leur publicitarisation constante et permanente. Elle fera date car elle installe un nouveau trope, une nouvelle figure de discours, qui considère comme normal, comme admis, comme naturel et nécessaire de convoquer ces artefacts génératifs au titre de témoins ou de preuve, leur agentivité se trouvant désormais consacrée sur l’autel de ce rituel païen que l’on nomme une émission et une chaîne d’information.

Avant que d’être tristement célèbre pour les viols et violences subies par des enfants dans un établissement religieux privé, la commune de Bétharram l’était pour ses grottes. A l’image du récit platonicien de la caverne, il serait grand temps d’enfin nous retourner pour poser dans le débat public tout autre chose que les ombres projetées de l’avis de ChatGPT.