Republication pour archivage et partage de l’article paru sur AOC.media le 20 Octobre 2025.

La question du langage s’est déplacée, et ce déplacement s’accélère de manière assez vertigineuse. Juin 2024 : mon livre « Les IA à l’assaut du cyberespace » revient sur les début tonitruants de ChatGPT et de ce que je nomme les « artefacts génératifs ». J’y pointe notamment les promesses encore maladroites de la génération de vidéos. Six mois plus tard, décembre 2024 : chacun reste bouche bée devant les prémisses des promesses de Sora d’OpenAI en termes de génération vidéo. Six mois plus tard encore, mai 2025, nous restons bouche bée devant cette fois Veo 3 de Google qui ajoute du son synchronisé à des vidéos toujours artificielles. Et en août 2025 c’est encore Google qui dévoile « Genie 3 », permettant de générer des mondes interactifs en temps réel à partir d’un simple prompt.

La question du langage s’est déplacée. C’est ce que depuis 25 ans et un peu plus, j’observe et documente à l’échelle de recherche qui est la mienne : celle de nos environnements numériques. Ces environnements avant-hier saturés de mots, puis hier encore d’images et de vidéos, et qui le sont désormais d’artefacts génératifs qui à leur tout sursaturent tant les mots que les images. Ad Libitum. Vertiges non d’une simple logorrhée mais d’une sorte de « technorrhée », l’emballement continu d’un capitalisme sémiotique ; une technorrhée pensée comme l’alliance chimiquement pure entre, d’une part, la merdification – « enshittification » – des médias sociaux en particulier et du web en général, et d’autre part, le « Brainrot » ou « abrutissement numérique » qui en est tout autant la cause que l’effet.

La question du langage s’est déplacée. Et dans ce déplacement, dans cette « différance » (Derrida), naissent et prennent place des mondes. Avec leurs images, leurs langages, leurs grammaires, et leurs vérités propres qui sont autant de singulières croyances. C’est dans cet écart par exemple que deviennent possibles, tristement et pathétiquement possibles, des images de Gaza transformée en Riviera, ou celles de soldats nazis défilant au milieu de résistants fêtant la fin de la guerre dans une vidéo mise en ligne par le pourtant très sérieux Service d’Information du Gouvernement (SIG). Dans ces déplacements du langage, dans ces « différances », et dans ces univers propres, cohabitent des représentations tenant aussi bien de délires, de fantasmes ou d’imaginaires que de saisissants réalismes.

Dans ce monde, dans ces mondes plus précisément qui sont aussi le nôtre, qui font en tout cas partie du nôtre, la frontière est extrêmement fine entre la capacité de ces technologies à nous laisser tout émerveillés et ahuris ou à nous transformer en autant d’abrutis totalement hébétés.

La question du langage s’est déplacée.

Et avec elle nos capacités à faire récit, à s’entendre et à s’écouter. Et avec elles, donc, notre capacité à faire société.

Longtemps cantonnées à la vallée de l’étrange, ces générations artificielles, ces vidéos notamment, n’ont aujourd’hui plus rien d’étrange dans leur rendu naturaliste. Fini les scènes animées où l’on détectait l’intervention de l’IA en regardant les mains et le nombre de doigts. Cela ne dispense pas ces générations d’erreurs factuelles ou contextuelles ou d’approximations, d’errances et d’hallucinations (nous y reviendrons) mais le photoréalisme est désormais totalement calculable. Certes le coût de ce calcul est vertigineux mais pour l’instant nous n’y prenons garde. Cette sortie de la vallée de l’étrange pour la plupart des contenus vidéos générés par IA (je parle ici de ceux qui ont vocation illustrative et non délirante ou seulement poético-ludique), nous fait entrer dans un monde … étrange. Une étrangeté qui ré-interroge notre capacité à dire le vrai, et surtout nos heuristiques de preuve, c’est à dire la manière dont collectivement nous pouvons attester que ceci s’est produit et s’inscrit dans une possibilité du monde que l’on appelle le réel.

On convoque souvent, à raison, l’argument selon lequel rien de tout cela ne serait vraiment nouveau. En effet l’invention de la peinture voit aussi l’invention des faussaires, l’invention de la photographie voit aussi celle de la retouche, avec l’invention du cinéma vient l’invention du truquage, et le développement de la radio et de la presse vont de pair avec celui des blagues, canulars, détournements, caricatures et fausses nouvelles. Mais les artefacts génératifs contemporains proposent une cinétique de représentations qui, à des échelles jamais atteintes d’usages massifiés et de circulations permanentes, cessent de nourrir nos imaginaires pour préférer les instancier, et ce faisant prive notre capacité individuelle et collective de recours à l’imaginaire d’une bonne part de sa puissance symbolique ; car tout est déjà là, car tout semble calculable et donc prévisible ; car tous les calculs ont été déjà faits ou le seront bientôt.

Pour bien saisir ce qui nous étreint et nous éreinte collectivement dans l’irruption de ces artefacts génératifs, il faut par exemple imaginer l’intérêt de l’écriture et le rôle d’un écrivain dans un monde où la bibliothèque infinie de Borges serait non seulement réelle mais dans laquelle chacun des ouvrages qu’elle contient serait surtout aisément accessible et consultable ; puisque tout est déjà là où peut l’être sur simple commande, alors la langue n’est plus un ouvroir de potentialités et d’imaginaires : elle semble n’être plus que la gangue de possibles concaténés, calculables et révélables.

Création, confiance et certification.

Sans refaire le débat du Phèdre de Platon et la condamnation de l’écriture, il est certain que quelque chose d’essentiel se joue aujourd’hui autour de la création, de la confiance et de la certification.

Création d’abord : qui peut encore être créateur/créatrice (dans le domaine des arts comme dans l’ensemble des métiers, tâches et fonctions de nos quotidiens) et de quelle manière l’être « avec », « à l’abri » ou « à l’écart » des artefacts génératifs ?

Confiance ensuite : comment avoir et faire confiance à celui ou celle qui crée dans l’originalité et l’intentionnalité de sa création ?

Certification enfin : comment certifier la part de cette création de la confiance qui peut ou doit lui être rattachée (et qui peut varier d’intensité et d’enjeu selon que ladite création concernera une oeuvre par exemple littéraire ou picturale, ou une décision médicale ou de justice) ? Des questions en triptyque que l’on ramène trop souvent à nos perceptions singulières alors qu’elles sont un bouleversement qui doit être pensé collectivement comme le suggérait Hervé Le Crosnier il y a … 30 ans de cela :

« La modification d’un document porteur de sens, de point de vue, d’expérience est problématique. Ce qui change dans le temps c’est la connaissance. Celle d’un environnement social et scientifique, celle d’un individu donné … Mais ce mouvement de la connaissance se construit à partir de référents stables que sont les documents publiés à un moment donné. Les peintres pratiquaient le « vernissage » des toiles afin de s’interdire toute retouche. Les imprimeurs apposaient « l’achevé d’imprimer ». Il convient d’élaborer de même un rite de publication sur le réseau afin que des points stables soient offerts à le lecture, à la critique, à la relecture … et parfois aussi à la réhabilitation. » Hervé Le Crosnier. « De l’(in)utilité de W3 : communication et information vont en bateau. » Présentation lors du congrès JRES’95, Chambéry, 22-24 Novembre 1995.

Ce que nous traversons avec l’IA dans sa dimension générative relève également d’un manque de ritualisation assumant la création de « points stables » qui fassent consensus ; mais apposer un label ou un filigrane « généré avec IA » ne suffira pas à construire ce repère car il ne s’agit plus ici de traiter seulement des questions de « modification » de documents porteurs de sens mais d’étendre ces points stables à des processus créatifs qui relèvent essentiellement de continuums complexes entremêlant des questions juridiques, économiques, techniques (informatiques) et éthiques.

Le temps des c(e)rises.

Nous sommes à ce moment de bascule où, pour l’instant, c’est comme si perdurait encore un effet Larsen dans l’esthétique de la réception de ces images et de ces vidéos ; comme si subsistait encore un bruit, une distorsion, un Larsen cognitif autant que collectif ; un Larsen qui ne s’éteint que lorsqu’enfin nous sommes à distance, à bonne distance, entre l’intention lisible de la génération et l’interprétation lucide de son effet sur nous ou sur le monde. Tant que cette distance n’est pas établie, ce bruit, ce doute, nécessaire, subsiste à l’horizon interprétatif : ce que nous voyons est-il réel malgré son photoréalisme ? Dès lors que cette distance est abolie – et tout est fait dans l’économie des plateformes pour y parvenir – alors ce bruit et ce doute s’éteignent, nous croyons ce que nous voyons. Or il n’est plus grand-chose de réel à voir dans ces enceintes.

Heuristique (et colégram).

C’est à chaque fois la même question qui revient et que je pointe (avec d’autres) depuis au moins 2011, parce que cette question est consubstancielle de chaque avancée technique qui touche à notre rapport au langage ou à l’image ou aux deux, c’est à dire à notre rapport au réel. Cette question c’est celle de savoir comme l’on bâtit de nouvelles heuristiques de preuve.

Il y a deux niveaux différents sur lesquels penser la complexification de nos anciennes heuristiques de preuve. D’abord la documentation récréative, ludique ou fictionnée du monde : l’enjeu est alors celui de la dissimulation ; il faut soit faire en sorte que le destinataire ne voit pas la simulation, soit qu’elle se dise pour ce qu’elle est (un « dit » de simulation) et qu’elle suscite l’étonnement sur sa nature. Et puis il y a la documentation rétrospective de tout ce qui fait histoire dans le temps long ainsi que celle qui concerne l’actualité. C’est alors l’exemple de la vidéo du SIG que j’évoquais plus haut, où le moindre casque à pointe nous fait basculer de l’ahurissement à l’abrutissement.

On croit souvent – et l’on s’abrite derrière cette croyance – que chaque simulation, chaque nouvelle production documentaire générée par intelligence artificielle, ajoute au réel. C’est totalement faux. Chaque nouvelle simulation enlève au réel. Parce que le réel historique n’est pas un réel extensible : il peut se nourrir de représentations historiques mouvantes au gré de l’historiographie et de l’émergence de preuves ou de témoignages, mais chaque nouvelle génération de ce réel historique potentiel va venir se sédimenter dans l’espace public mémoriel dont la part transmissible est extrêmement ténue et s’accommode mal d’effets de concurrences génératives. La question, dès lors, n’est pas tant de condamner les utilisations imbéciles ou négligentes de technologies d’IA pour illustrer un fait historique mais, par exemple, de savoir comment mieux rendre visible et faire pédagogie de la force incroyable d’authentiques images d’archives.

Nos imaginaires sont des réels en plus. Les effets de réel produits par les artefacts génératifs sont des imaginaires en moins.

Dans le domaine du langage les artefacts génératifs orientent bien plus qu’ils n’augmentent notre capacité à faire récit. Il se produit à peu de choses près ce que l’on avait déjà observé derrière la – fausse – promesse marketing initiale qui fut celle des grands réseaux sociaux généralistes : la promesse qu’en multipliant la diversité des profils, des origines, des croyances, des nationalités, des cultures auxquelles nous serions confrontés alors nous deviendrions plus ouverts, plus riches de liens sociaux, et plus empathiques. Or il se produisit essentiellement deux choses : d’abord cette exposition à une supposée diversité fut un feu de paille parce qu’elle allait contre la naturalité première de nos socialisations qui est de d’abord chercher celles et ceux qui nous sont semblables et que les plateformes, Facebook en tête s’aperçurent très vite que tout cela n’était pas bon pour le business (voir à ce sujet les travaux de danah boyd qui montra très tôt comment Facebook avait détruit l’expérience de la mixité sociale dans les universités de 1er cycle – « college » – aux états-unis). Ensuite les effets promis de proximité se transformèrent en effets subis de promiscuités effaçant toute forme d’empathie au profit de la dimension spéculative immédiatement virale et donc rentable de l’ensemble du spectre des discours de haine.

Il est en train de nous arriver exactement la même chose avec l’ensemble de l’actuelle panoplie des artefacts génératifs disponibles, de Genie 3 à ChatGPT5 : nous ne multiplions pas nos capacités collectives à faire récit (que ces récits soient imaginaires, réels ou réalistes et que leur support premier soit celui du texte, de l’image ou de la vidéo), nous les standardisons et nous nous enfonçons dans des dynamiques de reproduction qui se nourrissent de toutes les formes possibles de confusion ; une confusion entretenue par des formes complexes d’indiscernabilité qui tiennent à l’immensité non auditable des corpus sur lesquels ces IA et autres artefacts génératifs sont « entraînés » et ensuite calibrés.

Nous ne produisons pas davantage de nouveaux récits ou de nouveaux imaginaires mais, pour l’essentiel, nous reproduisons de manière industrielle toujours les mêmes, et après la phase de ce que l’on nomma des « hallucinations » vient aujourd’hui une autre phase, qui est celle de « l’effondrement » et qui désigne ce moment où les artefacts génératifs sont entraînés sur des contenus eux-mêmes artificiellement générés, des effondrements qui ruinent et minent les dynamiques d’interprétation et de représentation au fur et à mesure où celles-là mêmes sont érigées en modèles.

Au commencement était le mot-clé.

« En 2025 le web est donc un champ de ruine épistémique » écrit Thibault Prévost dans l’une de ses analyses à propos du phénomène de Slop AI, cette « technorrhée » symptôme de la merdification des plateformes et de notre expérience générale des environnement numériques. Je vous propose un (rapide) retour sur l’une des origines de cet effondrement qui fait qu’aujourd’hui et comme l’écrivait Balzac à propos d’une figure féminine de l’un de ses romans, la plupart de nos environnements numériques, dont le web, « n’ont plus que la beauté des villes sur lesquelles ont passé les laves d’un volcan. »

Au commencement donc était le mot-clé. Notre premier rapport au langage comme nouvelle agentivité opératoire sur une immensité de contenus non-ordonnés, c’est celui du mot-clé tel que les moteurs de recherche nous le proposèrent en prenant la suite des annuaires de recherche (lesquels catégorisaient en arborescence une série limitée de sites et pages choisies par des opérateurs humains). Ce mot-clé, longtemps utilisé seul, est de l’ordre de la formule incantatoire : écrivez « voyage » et vous trouverez les destinations et les prix et les conditions et les descriptions de vos destinations y compris celles non-choisies ; écrivez « voyage » et vous voyagerez. Nous ne donnons qu’un seul mot, qu’une seule clé, et nous attendons de recevoir un monde ordonné, accessible et surtout un monde soit « pertinent » (c’est à dire depuis le début aussi conforme que possible à notre propre désir), soit « populaire » (c’est à dire aussi conforme que possible au désir des autres, ce que René Girard appelle le désir mimétique). Un seul mot et en face, l’immensité ordonnée de pages choisies et triées dans l’économie libidinale où nous sommes passés du statut de déclamant à celui de simple variable statistique dans une chaîne de production qui ne vise que son propre maintient.

Puis de plus en plus, à la place des mots (clés), nous avons fait des phrases. Nous sommes partis à la conquête du langage naturel. Nous avons donc discouru avec des machines, avec des algorithmes. Qui en retour de notre déclamation naturelle, se mirent à nous répondre non plus sous forme de liste de sites, mais d’extraits choisis et signifiants.

Et puis lassés de leur écrire autant que par la simple possibilité offerte de le faire, nous leur avons parlé. Les interfaces vocales se sont proposées, souvent imposées. De cette vocalisation nouvelle sont nées en retour d’autres échos sonores : ceux des machines et de algorithmes nous répondant, prenant voix. Siri, Alexa, et les autres. World Wide Voice.

Il y a l’initiative de la parole, de la requête, de la question. Et l’espace de la réponse. Car durant tout ce temps, de nos premiers mots-clés balbutiés à nos dernières commandes vocales prononcées, s’est structuré un espace matériel du recueil de nos expressions, une géographie politique de nos espaces de parole, de nos espaces discursifs, singuliers et partagés.

Le passage du web aux plateformes, aux « jardins fermés » comme les appelle Tim Berners-Lee, ne fut pas simplement le passage d’un espace public à des espaces semi-privés. Il fut aussi celui où ces plateformes délimitèrent en nombre l’espace de nos énonciations possibles. On décrit souvent le numérique comme un espace de publication illimité, ce que fut et que demeure le web en effet, mais les plateformes, toutes les plateformes, ont installé des espaces discursifs bornés, limités, frustrants, dont rien ne peut ni ne doit dépasser tels de modernes Procuste, ce bandit qui dans la mythologie proposait aux gens de les héberger avant que de leur couper les membres qui dépassaient de son lit.

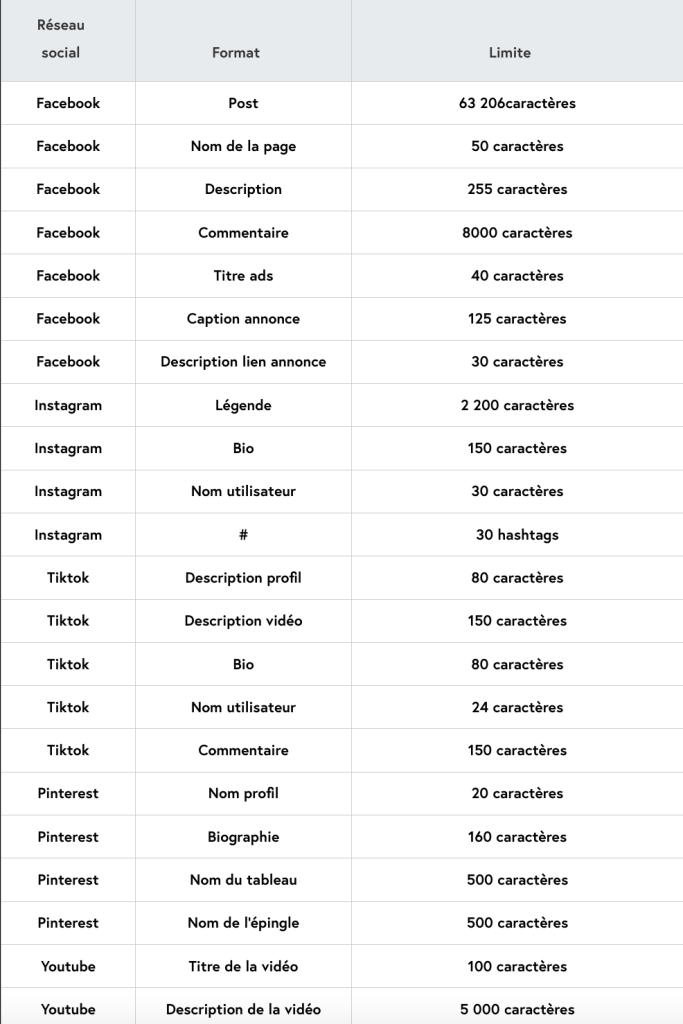

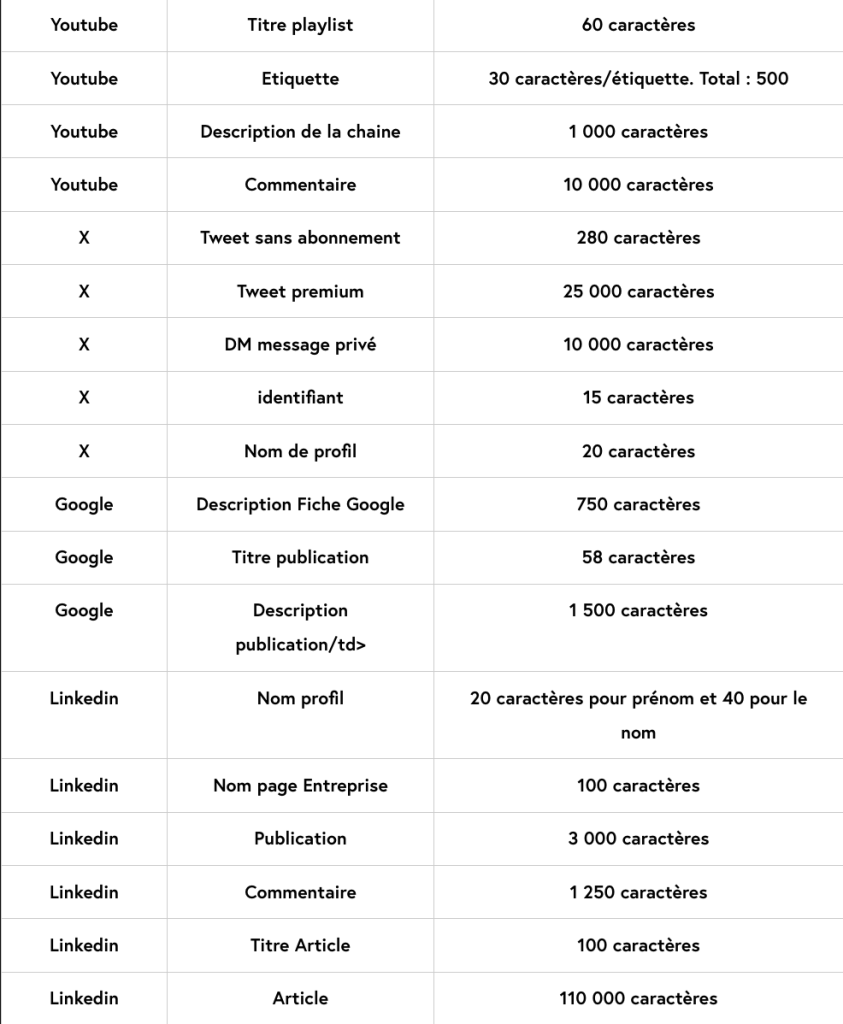

Procuste dans l’histoire des plateformes c’est 140 signes sur Twitter puis 280 sur X, 2200 signes sur Instagram, 3000 pour LinkedIn, 150 signes pour une vidéo TikTok et 5000 signes pour décrire une vidéo Youtube. Malgré l’extension du domaine de la statusphère, Et tout le reste de ces espaces tant limités que limitrophes d’une atrophie des possibles.

(source : Dailyfy.co)

Comme le montre ce tableau, chaque espace est catégorisé par sa nature « titre de publication », « nom de la page », « description », « commentaire », « description vidéo », « bio », « DM message privé », etc. Et à chaque catégorie un autre espace, une autre limite : 58 caractères pour un titre de publication, 80 caractères pour une bio Tiktok, 30 pour un nom de profil Instagram, 1250 pour un commentaire LinkedIn, et ainsi de suite. Tout est métrique. A coups de trique. Quelques grands espaces demeurent : 110 000 caractères l’article LinkedIn mais 3000 caractères la « publication » de la même plateforme ; 63206 caractères le le post Facebook mais 8000 seulement pour le commentaire. Le numérique des plateformes est tout sauf l’espace infini qui était celui de la publication web des années 2000, c’est un espace totalement sous contrainte et en permanence sous astreinte.

Aujourd’hui l’essentiel de nos espaces discursifs en ligne qui ont recours au langage indépendamment de l’image ou de la vidéo sont des espaces Procustéens (images et vidéos par ailleurs elles-mêmes soumises à des limitations de durée). Des espaces où l’énonciation, où l’accès à la capacité de dire, ne vaut que par l’acceptation de cet horizon court de la diction. Certes il est possible, et certains y parviennent, de sublimer ces limites en les esthétisant ou en les poétisant. Les formes courtes ont par ailleurs une existence culturelle et littéraire longue. Mais nous parlons ici des conditions de production de la langue et donc du réel à l’échelle d’une humanité toute entière, en tout cas de sa part connectée (près de 5,5 milliards d’êtres humains). La « merdification » (enshittification) des plateformes, de presque toutes les énonciations qui s’y déploient aujourd’hui, est aussi liée à cela. Ces espaces ne nous offrent pas tant la possibilité de dire qu’ils ne nous imposent la nécessité de rapidement nous taire. Il est d’ailleurs singulier de voir les plateformes parler de « liberté d’expression » dans des espaces aussi bornés et limités que ceux qu’elles nous offrent. Parlerait-on d’une « liberté de circulation » si celle-ci se limitait à un déplacement entre notre chambre et nos toilettes ?

D’un côté donc, il y eut, à l’échelle des plateformes numériques, la multiplication des espaces d’expression possibles. Mais en parallèle chaque nouvel espace énonciatif est apparu comme permettant de cadrer et de limiter « en nombre » toute expression singulière en ligne. Et désormais il y a la contamination de l’ensemble de ces espaces par des tiers énonciatifs logorrhéiques dopés à l’IA et aux artefacts génératifs. Voilà pour la parole « en émission ».

Quand à la parole « en réception », nous sommes aujourd’hui de plus en plus confrontés et exposés à ces dispositifs techno-logorrhéiques à proportion inverse de nos propres capacités à nourrir et à alimenter ces espaces expressifs et énonciatifs. Pour le dire plus trivialement : la part des bots et des contenus artificiellement générés explose et contamine l’ensemble des espaces numériques de l’ensemble des plateformes (c’est l’un des thèmes de mon livre « Les IA à l’assaut du cyberespace : vers un web synthétique » paru l’été dernier chez C&F Editions).

A l’échelle du numérique, si l’humanité se figeait à ce moment précis, et si nous l’observions à l’échelle macroscopique, nous serions alors forcés de constater que l’initiative de la parole, de la conversation, de la langue comme interaction et comme compréhension, que cette initiative revient davantage aux machines qu’à nous-mêmes. Et que notre réel s’y consomme d’abord, puis s’y épuise et s’y consume. Je le redis, chaque nouvelle simulation enlève au réel. Quand Trump annonce vouloir transformer Gaza en Riviera, des milliers d’images et de vidéos « génératives » viennent instantanément illustrer, montrer, filmer, documenter cet impossible, ce délire macabre autant que cynique. Ce qui était et aurait du rester impossible, y compris à formuler, devient sous le poids des générations illustratives un embranchement possible du futur qui nous est proposé comme instantanément disponible pour nos sens et nos imaginaires. C’est en cela qu’il enlève au réel, au seul réel possible qui est celui d’un arrêt des massacres en cours. Il ne s’agit pas uniquement d’élargir la fenêtre d’Overton mais bien de bâtir autour d’elle l’ensemble la totalité de la barre d’immeuble où elle ne sera plus qu’une fenêtre parmi d’autres, de faire exister la réalité qu’elle inaugure pour laisser au réel encore moins de chance de pouvoir la limiter ou la contraindre rapidement. C’est aussi cela que Trump a sinon compris, du moins intuitivement senti, et qui le fait tant à l’aise dans ces médias sociaux où prime l’expression courte et bouffonne : la parole politique, sa parole politique, se suffit au lit de Procuste tant que l’image y tient les dimensions voulues. Gaza en Riviera. Voilà ce qui seul doit tenir. Le reste s’abîme, s’épuise et s’effondre derrière ces dispositifs techno[-logo]rrhéiques pensés pour l’emballement viral et dont les IA et autres artefacts génératifs ne sont que la dernière – mais non ultime – instance contemporaine.

Les 3 chambres.

Depuis longtemps dans l’analyse des médias on utilise le concept de « chambre d’écho » pour désigner de manière métaphorique, le fait que « l’information, les idées, ou les croyances sont amplifiées ou renforcées par la communication et la répétition dans un système défini. »

Avec l’arrivée des médias sociaux, se fait jour chez Eli Pariser le concept de « bulle(s) de filtre« , cette idée que les algorithmes des moteurs de recherche comme des grands médias sociaux tendent à nous enfermer dans nos propres croyances et convictions.

Aujourd’hui, avec l’essor et la place que prennent les différents artefacts génératifs à l’identique de ChatGPT, des chercheurs (Jacob, Kerrigan, Bastos 2025) parlent d’un « Chat-Chamber effect ». Rien à voir avec les matous qui ont conquis l’internet, le « chat » doit être lu et compris comme le « Tchat », et caractérise l’un des biais de nos échanges conversationnels avec des artefacts génératifs, lequel biais désigne les informations incorrectes mais allant dans le sens du questionnement de l’utilisateur que les grands modèles de langage peuvent fournir ; des résultats et informations qui restent non contrôlées et non vérifiées par les mêmes utilisateurs mais auxquels ces mêmes utilisateurs font pourtant confiance. Le titre complet de leur article est ainsi : « L’effet ‘Chat-Chamber’ : faire confiance aux hallucinations de l’IA« .

Derrière ces 3 déclinaisons d’une même tendance à trois époques contemporaines successives, se jouent deux choses. D’abord des dynamiques médiatiques qui s’interpénètrent pour forger, favoriser et figer une certaine logique ou esthétique de réception des discours qui s’y tiennent. Ensuite une affordance informationnelle première qui est l’inverse du doute raisonnable : ces systèmes médiatiques ont pour affordance première leur capacité à nous faire croire qu’ils disent le vrai : les logiques virales de partage (« si c’est tant partagé c’est bien que ça doit être vrai« ), le dispositif de proximité (illusoire) avec l’énonciateur (« si c’est lui qui le dit alors cela doit être vrai« ), le biais de disponibilité (des informations délibérément erronées ou mensongères sont plus immédiatement accessibles et rendus visibles que d’autres plus sourcées) ne sont que quelques-uns des leviers de cette affordance de vérité supposée.

Depuis plus de 20 ans j’explique et documente le fait que les algorithmes sont des éditorialistes comme les autres, mais qui avancent essentiellement masqués et que les IA et autres artefacts génératifs installent dans une sorte de théâtre total, « gestes, sons, paroles, feus, cris« , dont plus personne n’est en capacité de comprendre les codes.

A.M.I. : Assemblage Machinique Informationnel.

L’arrivée des artefacts génératifs ajoute une dimension nouvelle et passablement problématique au tableau contemporain de la fabrication de nos croyances et adhésions. Jusqu’ici, moteurs de recherche et réseaux sociaux jouaient sur le levier déjà immensément puissant de leurs arbitraires d’indexation et de publication (le fait de choisir ce qu’ils allaient indexer et/ou publier) ainsi que sur celui, tout aussi puissant, de la hiérarchisation et de la circulation (viralisation) de ce qui pouvait être vu et donc en creux de ce qu’ils estimaient devoir l’être moins ou pas du tout.

Choisir quoi mettre à la « Une » et définir l’agenda médiatique selon le vieux précepte de « l’agenda setting » qui dit que les médias ne nous disent pas ce qu’il faut penser mais ce à quoi il faut penser. Ce principe premier de l’éditorialisation se double, avec les artefacts génératifs conversationnels à vocation de recherche, d’une capacité à produire des sortes d’assemblages machiniques informationnels, c’est à dire des contenus uniquement déterminés par ce que nous interprétons comme un « devenir machine** » en capacité de « phraser » les immenses bases de données textuelles sur lesquelles il repose. Des machines à communiquer mais en aucun cas, comme le souligne aussi Arthur Perret, en aucun cas des machines à informer.

** [ce « devenir-machine » est à lire dans le sens du « devenir-animal » chez Deleuze et Guattari : « le “devenir-animal” ne consiste pas à “imiter l’animal, mais d’entrer dans des rapports de composition, d’affect et d’intensité sensible” ».]

Ce concept d’assemblage machinique informationnel me semble intéressant à penser en miroir ou en leurre des agencements collectifs d’énonciation théorisés par Félix Guattari. D’abord parce qu’un assemblage n’est pas un agencement. Il n’en a justement pas l’agentivité. Il n’est mû par aucune intentionnalité, par aucun désir combinatoire, calculatoire, informationnel, communicationnel ou social. Ensuite parce que la dimension machinique est antithétique de la dimension collective, elle en est la matière noire : ChatGPT (et les autres artefacts génératifs) n’est rien sans la base de connaissance sur laquelle il repose et les immenses réservoirs de textes, d’images et de contenus divers qui ont été, pour le coup, assemblés, et sont l’oeuvre de singularités fondues dans un collectif qui n’a jamais été mobilisé ou sollicité en tant que tel. Enfin, l’information est ici un degré zéro de l’énonciation. L’énonciation c’est précisément ce qui va donner un corps social à ce qui étymologiquement, a donc déjà été « mis en forme » (in-formare) et se trouve prêt à être transmis, à trouver résonance. ChatGPT est l’ombre, le simulacre, le leurre d’une énonciation. Et cette duperie est aussi sa plus grande victoire.

La question du langage s’est déplacée. Un grand déplacement. Quelque chose qui n’est plus aligné entre le territoire du monde et la langue qui en est la carte.

Apostille(s).

Pendant que nos réels sont saturés et épuisés d’IA, en Israël, un spot de publicité pour une entreprise d’armement utilise pour la première fois des images réelles d’une attaque de drone à Gaza. C’est à la fois la plus cynique et la plus perverse des formes de publicitarisation. Pendant ce temps Youtube dévoile un système baptisé « Peak Points » qui utilise son IA « Gemini » pour insérer des publicités aux moments où l’attention des spectateurs est supposément la plus forte grâce à l’exploitation de données « émotionnelles » (ou qui sont en tout cas supposées rendre compte de notre état émotionnel).

Couplez maintenant ces deux informations et déterminez sans algorithme votre propre état émotionnel …

De manière plus anecdotique, on constate un jaunissement par contamination de nombreuses images générées artificiellement. Les animaux étaient malades de la peste, les IA le sont déjà de consanguinité. Pendant ce temps encore, Youtube fait des retouches de vidéos sans en avertir les créateurs, pour « rapprocher esthétiquement le rendu des vidéos de ce que l’IA générative peut proposer. » Standardiser la consanguinité des contenus générés.

Pendant ce temps, des images pédocriminelles générées par IA sèment autant le trouble que le doute et entravent les démarches déjà si complexes du travail de police et de justice. La volumétrie des faux-positifs est ici la première alliée des pédocriminels. Et une nouvelle fois la charge de la preuve s’inverse comme si souvent dans l’histoire du numérique : il ne s’agit plus de pouvoir détecter la marginalité de faux-positifs sur un volume de contenus donnés, il s’agit de la maximiser pour que les résultats « sincères » soient marginalisés.

En 1985, dans un entretien où elle était interrogée sur sa vision de l’an 2000, Marguerite Duras prophétisait avec une rare acuité « Il n’y aura plus que des réponses. Tous les textes seront des réponses. (…) » Nous sommes au moment où tout comme après l’avènement des moteurs de recherche au début des années 2000, il n’y a plus, aujourd’hui, que des réponses. De fausses réponses pourrait-on donc ajouter.

Marguerite Duras poursuivait : « Un jour un homme il lira. Et puis tout recommencera. » L’inflation des artefacts génératifs dans l’ensemble de nos écosystèmes informationnels et des sphères de nos savoirs sociaux (école, université, cercles politiques, etc.) pose autant la question de savoir ce qu’il restera encore à lire, que celle de savoir si nous serons en peine d’encore pouvoir écrire un destin commun. Christian Salmon le rappelait aussi dans sa récente analyse sur ce nouvel ordre narratif en train de s’imposer : « La prolifération de ces narrations non humaines interroge le devenir de l’humanité tout entière. »

La question du langage s’est déplacée, et notre technorrhée ressemble à s’y méprendre aux vers de Macbeth : un conte raconté par un idiot (ils sont en fait plusieurs), plein de bruit et de fureur, ne signifiant plus rien. (« It is a tale / Told by an idiot, full of sound and fury / Signifying nothing« ).

Bonjour Olivier, en début d’année j’ai publié 95000 mots sur la question… https://zenodo.org/records/18167888 et je suis en préparation d’un document intitulé « Pour une théorie et une pratique du sens à l’ère des modèles

Herméneutique, répondabilité et interprétations », vaste programme !

Bonne année 2026 🙂

Merci pour ce texte que je lis avec bonheur en cette soirée du 25 janvier 2025.

Et que je relirai dans la semaine et les semaines à venir. Il est plein de sources de réflexions et de questionnement sur les temps qui viennent et ma pratique artistique dans ces monde du Web et de la vraie vie tels qu’ils se dessinent et s’affrontent.

Avec l’espoir que la vraie vie gagnera sans pour autant nous éjecter de ce monde du Web à la cartographie désormais si étrange.

En se gardant difficilement des intrusions des algorithmes et autres artefacts.

Revenir aux collages muraux peut être esthétiquement « chouette » mais l’univers se rétrécit fortement du coup.

Au plaisir de vous lire ou de rire comme a votre candidature à ce bullshit job en pays nantais.

Catherine Guillou