[Boite noire] Cet article a initialement été rédigé durant le mois d’Août 2023. Il a donné suite à une version (très très très) courte, centrée sur la toute fin de mon argumentaire, autour d’un web « synthétique », version publiée dans Le Monde du 7 Octobre et republiée ici pour archivage quelques jours plus tard dans une version légèrement augmentée. [/Boite noire]

—————————————————————

Depuis quelques années on appelle cela le « small talk », une petite conversation polie ou l’on parle de tout mais surtout de rien. Je veux ici vous parler du « scroll talk » et d’un avenir dans lequel, possiblement, des agents conversationnels (talk) seraient nos principaux prescripteurs de navigation (scroll).

Mais revenons d’abord au « small talk », à ses dérivés et déclinaisons et à leur prégnance dans nos univers sociaux numériques.

La philosophe Gloria Origgi avait, il y a plus de 10 ans, formé le terme de « kakonomie », permettant de désigner « l’étrange mais très largement partagée préférence pour des échanges médiocres tant que personne ne trouve à s’en plaindre. (…) La kakonomie est régulée par une norme sociale tacite visant à brader la qualité, une acceptation mutuelle pour un résultat médiocre satisfaisant les deux parties, aussi longtemps qu’elles continuent d’affirmer publiquement que leurs échanges revêtent en fait une forte valeur ajoutée. »

Le sociologue Erving Goffman, à la fin des années 1950, parlait de son côté de « rituels » et « d’activités cérémonielles » où l’on joue à être ce que l’on est ou à s’aligner sur la représentation de soi que l’on pense attendue par les autres, à l’image du garçon de café de Sartre.

Il est assez facile de voir à quel point le concept de kakonomie ou la part de l’oeuvre de Goffman consacrée aux interactions sociales sont fécondes pour analyser ce qui se joue dans nos interactions en ligne (ainsi que dans la construction actuelle d’une grosse partie des productions médiatiques cinématographiques ou télévisuelles).

Avec l’arrivée de la publicité et du marketing ainsi que des sciences de gestion qui en sont pour partie l’appareillage théorique, on a vu émerger différentes méthodes plus ou moins triviales de modélisation des intentions d’achat, pour l’essentiel basées sur les travaux de l’école de Palo Alto (pour l’anthropologie et les sciences de la communication) ou de celles de Chicago (pour la dimension sociologique).

Parmi ces méthodes, l’une des plus connues est celle dite des « persona », c’est à dire « un profil de personne créé de manière fictive par les entreprises dans le but de se rapprocher au plus près de leur client cible. C’est en quelque sorte le portrait-robot d’un groupe de clients potentiels. »

Mon nom est persona.

Une indiscrétion collectée par le Financial Times révèle que Zuckerberg travaillerait sur le lancement, à la rentrée, « d’une gamme de chatbots (agents conversationnels) dotés d’une intelligence artificielle et présentant différentes personnalités, dans le but de stimuler l’engagement sur ses plates-formes de médias sociaux. » Cette gamme vient en effet d’être lancée le 27 Septembre 2023 :

« Chacune a son petit nom, et surtout une spécialité : Bru est le spécialiste des sports, Billie est la grande sœur, Lorena la férue de voyage et Max le chef cuistot. Même s’ils sont tous basés sur le même modèle de langage, chacune s’est vu prêter une sorte de « personnalité ». Et chacune se voit aussi prêter un visage : et ce sont des personnalités qui ont accepté de prêter leur apparence à ces « amis imaginaires ». Ainsi, le rappeur Snoop Dogg est le « dungeon master » spécialisé en jeux de rôle, et c’est Paris Hilton qui incarne Amber, la détective. Pour l’heure, ces avatars sont juste des photos animées, mais à terme, c’est leur visage et leur voix, animés par l’IA, qui répondront directement. »

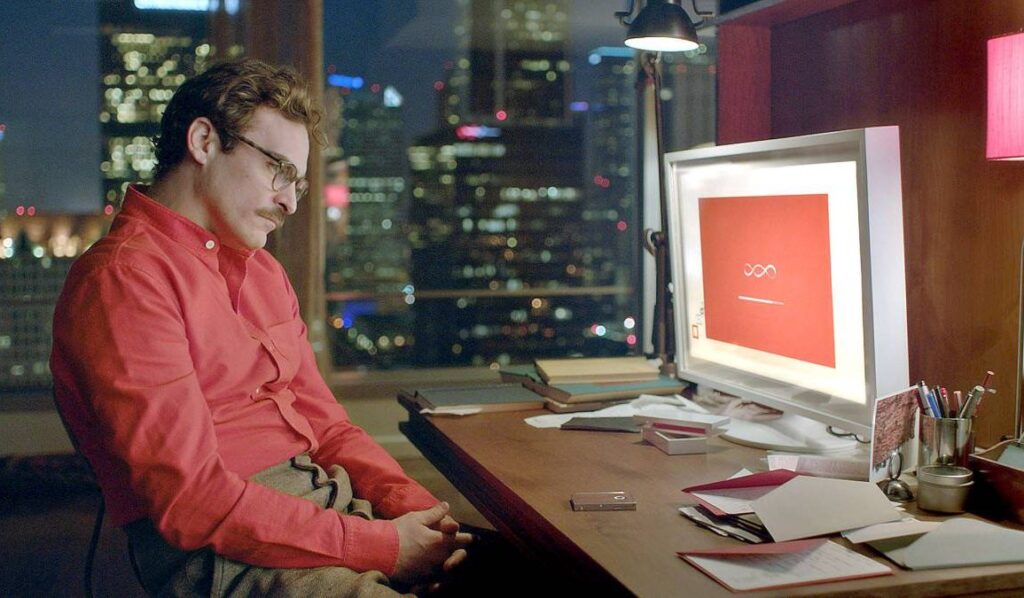

« Her » de Spike Jonze. Film (magnifique) dans lequel le héros tombe amoureux d’une intelligence artificielle.

Et réciproquement. Formidable fable et réflexion philosophique autour de notre relation aux machines et aux voix.

Le monde informationnel et communicationnel dans lequel nous évoluons est un monde dans lequel – selon notre âge, notre éducation, notre niveau de revenus et différents autres paramètres sociologiques – beaucoup de nos interactions sociales sont principalement médiées et modalisées « par » et « dans » des interactions en ligne.

Comme individu connecté dans une planète comptant près de 5 milliards d’internautes, nous avons des interactions sociales numériques régulières avec des communautés bien plus larges et denses que dans le monde physique, même si naturellement, ces relations n’ont, quantitativement comme qualitativement, pas de traduction possible supportable en dehors de ces médias sociaux, ce qui, en creux, permet aussi de définir pour partie leur nature.

Elles n’en demeurent pas moins des interactions sociales, analysables, modélisables et explicables à l’aide des concepts de l’oeuvre de Goffman (et d’autres bien sûr) : remplies de petites cérémonies et de langages indiciaires qui permettent de nous inscrire dans différents cadres expressifs et discursifs qui sont autant de scripts que nous pouvons suivre ou dont nous pouvons choisir de nous détacher.

En admettant que des agents conversationnels puissent faire illusion de maîtrise du langage et que nous ne soyons pas en capacité, en volonté ou en situation de les identifier comme tels, nous agirions alors avec eux comme nous avons l’habitude d’agir avec des profils « authentiques ». C’est d’ailleurs déjà le cas dans certaines plateformes lorsque, par exemple, nous commentons ou rediffusons le contenu porté par un compte automatisé que nous ne savons pas être tel.

Pour autant que ces agents autonomes puissent être dotés d’une « personnalité » (j’y reviendrai plus tard), cela veut dire qu’une énième vallée de l’étrange va se mettre en place, dans laquelle il importera de déterminer quels sont les cadres mis en place pour nous permettre d’identifier ces agents conversationnels dotés d’une personnalité, ou à l’inverse pour nous les dissimuler et les rendre aussi présents que possible dans les échanges en restant aussi discret que possible sur leur vraie nature artefactuelle.

Rien de personnel.

Revenons au projet de Zuckerberg de lancer des bots dopés à l’IA et dotés de « personnalités ». Et commençons par un petit retour vers le futur.

La question des « agents conversationnels » constitua il y a quelques années de cela, lorsque l’on commençait à parler du « web sémantique » (à partir de Mai 2001), la promesse d’un futur désirable. On imaginait alors que chacun pourrait disposer de « son » agent conversationnel personnalisé, qui serait à la fois à l’image d’un.e secrétaire et d’un compagnon. Puis vinrent Siri, Alexa, OK Google et les autres. Et la norme du marché devînt celle d’une vocalisation performative de requêtes. Un progrès certes mais bien loin des attentes et des fantasmes conversationnels initiaux, fantasmes pour partie anthropomorphiques.

Et puis vînt la révolution du Deep Learning et d’un renouveau des technologies utilisées dans le cadre de travaux autour de l’intelligence artificielle et l’arrivée des grands modèles de langage (Large Language Models) ainsi que de leur héraut et de leur perroquet stochastique premier, j’ai nommé : ChatGPT.

Ce fut alors le temps du lancement d’une nouvelle génération de bots « conversationnels » dont beaucoup reposent en partie ou en totalité sur ChatGPT ou des modèles de langage équivalents : My AI sur Snapchat, bientôt Tako pour TikTok. Et donc demain (peut-être) les chatbots conversationnels lancés par Méta et dotés de « personnalités » (sur la base de son grand modèle de langage baptisé Llama 2).

Toujours selon l’article du Financial Times :

« M. Zuckerberg a déclaré qu’il envisageait des « agents d’IA qui agissent comme des assistants, des coachs ou qui peuvent vous aider à interagir avec des entreprises et des créateurs », ajoutant : « Nous ne pensons pas qu’il y aura une seule IA avec laquelle les gens interagiront.«

Il y a déjà 7 ans de cela on imaginait que la construction d’une personnalité pour ces bots deviendrait un marché sur lequel on recruterait des « façonneurs de personnalités » pour ces intelligence artificielles, des sortes de scénaristes de l’IA, afin de les « éduquer », de les cadrer, de leur éviter autant que possible de partir totalement en vrille. Et puis vinrent les grands modèles de langage et le Deep Learning à son apogée, principalement portés par les Big Tech, qui plutôt que des emplois qualifiés permettant d’y parvenir à grands frais autant qu’à petite échelle, firent le choix de sous-traiter ces procédures dites de « fine tuning » (où, pour faire simple, on « affine » le modèle selon le contexte d’utilisation) à des travailleurs exploités au Kenya, notamment par l’entreprise sous-traitante (et mal-traitante) Sama, comme a permis le le révéler l’enquête du Time (reprise et synthétisée en français par différents médias dont France 24), écrivant une nouvelle page de l’histoire du Digital Labor.

These Bots are made for stalking.

Dans l’intervalle de ces quelques années, des écosystèmes numériques entiers, ces plateformes de médias sociaux capables de rassembler et d’enfermer l’essentiel de nos conversations et de nos échanges en ligne, furent littéralement envahis par un grand nombre de « bots », c’est à dire de comptes automatisant des fonctionnalités de publication, de correction, d’interaction. Pour de bonnes raisons (la correction de fautes d’orthographe dans Wikipédia par exemple), ou de mauvaises raisons (des opérations de désinformation ou de propagande, du harcèlement en meute, etc.).

Les bots malveillants interagissent avec les applications comme le feraient des utilisateurs légitimes, ce qui les rend plus difficiles à détecter et à bloquer. Ils abusent de la logique commerciale en exploitant le mode de fonctionnement d’une entreprise, plutôt que d’exploiter des vulnérabilités techniques. Ils permettent (…) des utilisations abusives et des attaques à grande vitesse sur les sites web, les applications mobiles et les API. Ils permettent aux opérateurs de robots, aux attaquants, aux concurrents peu recommandables et aux fraudeurs d’effectuer un large éventail d’activités malveillantes. Ces activités comprennent le web scraping, le data mining concurrentiel, la collecte de données personnelles et financières, la connexion par force brute, le scalping, la fraude publicitaire numérique, le déni de service, le spam, la fraude transactionnelle, et bien plus encore. Ils peuvent consommer de la bande passante, ralentir les serveurs et voler des données sensibles, ce qui entraîne des pertes financières et peut porter atteinte à la réputation d’une entreprise. (Imperva « Bad Bot Report », 2023)

Qu’il s’agisse de « bons » ou de « mauvais » bots, la part et le le nombre de ces comptes à l’échelle d’un écosystème en particulier comme de l’ensemble des médias sociaux est extrêmement difficile à quantifier précisément. Mais on avait eu un aperçu assez Rock’n Roll de l’enjeu de cette mesure lorsqu’Elon Musk se lança dans le rachat de Twitter, en utilisant comme argument de négociation le fait que le nombre d’utilisateurs « réels » de la plateforme serait largement surestimé et que celui du nombre de « bots » serait tout autant sous-estimé et que donc la valeur marchande de la base d’utilisateurs devait être revue à la baisse. Il avait ensuite promis de faire un grand ménage dans ces bots. Fin de la blague.

Même si le nombre de bots est très difficile à évaluer, des études comme celle de la société Imperva et son « Bad Bot Report » 2023, permettent d’approcher le phénomène. C’est presque la moitié (48%) du « trafic » sur le web qui serait généré par des bots et donc par des interactions « non-humaines » (même s’il est bien sûr des humains derrière ces bots, ne serait-ce que pour les programmer et les maintenir, et que cela pose d’éminents problèmes en terme de Digital labor, voir notamment les travaux d’Antonio Casilli sur ce sujet).

La totalité du « trafic » sur le web serait donc quasi-hémiplégique :

Selon le dixième Bad Bot Report émis par la société Imperva, 47,4 % du trafic internet a été produit en 2022 par des bots. Une augmentation en à peine un an de 5,1 % (…) Avec sa maigre majorité de 52,6 % du trafic, l’utilisation humaine est à son plus bas depuis les 8 dernières années. (…) Sauf que le développement des « mauvais bots » est aussi à la hausse.

Ces mauvais bots, exploités à des fins d’abus, de détournement et d’attaques, ont représenté l’an dernier 30,2 % du trafic, soit une augmentation de 2,5 % par rapport à 2021. Pire, leur sophistication ne fait que s’accroître au fil du temps. En 2022, les bots à but malicieux techniquement avancés comptaient pour plus de la moitié du trafic de bots (51,2 %), un véritable bond en avant par rapport à 2021 (25,9 %). (Source : Clubic)

Par-delà le seul paramètre du trafic « vers » les sites web et les plateformes, il faut aussi s’interroger sur la quantification des interactions à l’intérieur de chaque grande plateforme de média social. Combien de comptes Twitter / X sont en fait des bots et/ou des comptes frauduleux (scams) ? Et pour Facebook ? Instagram ? Snapchat ? TikTok ?

Rien que pour Twitter, les chiffres oscillent entre 5% (selon … Twitter), et plus de 80% (selon la police), avec d’autres estimations autour de 20% pour des sites spécialisés comme Botometer.

Mais l’essor phénoménal de ces « robots sociaux » (voir l’article « The Rise of Social Bots« ) ne se résume pas à une approche quantitative. Comme rappelé par ces deux chercheurs :

Grâce à BotAmp, un nouvel outil de la famille Botometer que toute personne disposant d’un compte Twitter peut utiliser, nous avons constaté que la présence d’activités automatisées n’est pas uniformément répartie. Par exemple, les discussions sur les crypto-monnaies ont tendance à montrer plus d’activités automatisées que les discussions sur les chats. Par conséquent, que la prévalence globale soit de 5 % ou de 20 % ne fait guère de différence pour les utilisateurs individuels ; leurs expériences avec ces comptes dépendent des personnes qu’ils suivent et des sujets qui les intéressent.

La polémique du rachat de Twitter par Musk en partie centrée sur le nombre réel de bots de la plateforme, l’essor et la banalisation des agents conversationnels dopés à l’IA, l’annonce récente de Zuckerberg sur ces futurs bots dotés de personnalités, une importante littérature scientifique mais aussi l’observation participante continue depuis plus de 15 ans de ces différentes plateformes, tous ces signes, études et indices permettent d’affirmer que tendanciellement nous nous dirigeons vers le même type d’hémiplégie navigationnelle où presque la moitié du trafic est généré par les bots, mais cette fois à l’échelle conversationnelle et interactionnelle. Une triple hémiplégie donc : navigationnelle, mais aussi conversationnelle et interactionnelle.

Non seulement il est plus que probable qu’à moyen terme, pas loin de la moitié de nos conversations et de nos interactions se fassent avec différents types de bots, mais il est également plus que probable que ces conversations et interactions soient à leur tour scindées en deux groupes inégaux : celui des conversations et interactions où nous aurons conscience d’être en présence d’un bot, et celui où nous n’en aurons absolument aucune idée.

Vertiges.

Il y a aujourd’hui une forme de vertige. Vertige de constater l’importance de nos interactions par ou avec des bots. Vertige de constater que pour les Big Tech l’avenir semble être celui de toujours plus de bots « personnels », « personnalisés » et donc maintenant « avec des personnalités » (sic).

Vertige d’une nouvelle fois voir s’opérer un renversement, celui où c’est nous qui devenons les supplétifs commodes et malléables d’un projet de marchandisation global des comportements sociaux, celui où c’est nous qui sommes au service de ces bots (et des sociétés qui les contrôlent ou les laissent circuler).

Vertige de savoir que désormais chacune de nos interactions, en plus de servir à nourrir des modèles de ciblage marketing, sert aussi à nourrir des intelligences artificielles entraînées sur de gigantesques modèles de langage eux-même nourris de nos interactions et conversations avec des bots afin d’être en capacité de produire … des bots capables de nous amener à davantage d’interactions et de conversations avec eux et avec les plateformes qui les hébergent.

Vertige de se demander quel est l’objet et la finalité de ce qui semble être une inflation discursive constante et inarrêtable. Vertige de constater aussi que chacune des conversations et des interactions formatées ou attendues auxquelles ces écosystèmes nous éduquent et nous entraînent en permanence ne nourrissent plus aucune forme d’intelligence collective. D’autant que cette inflation pose en miroir le problème et la difficulté de sa conservation. Or il est vital de conserver une partie de ce qui circule en ligne, comme le proposent des organismes et institutions aussi différentes que l’Internet Archive ou la BnF dans le cadre du dépôt légal du web. Et si l’archivage du web a toujours été un sujet complexe (techniquement, légalement et en termes d’archivistique donc), cette inflation discursive pose et posera indéniablement de nouveaux problèmes de nature bibliothéconomiques (qui ne sont certes pas les plus préoccupants au plan sociétal mais ne doivent pas pour autant être négligés ou absents du débat public). Car en face de cette inflation qui sature l’espace et l’horizon du débat public, on observe, comme le remarquait Jonathan Zittrain en Juin 2021, que « l’internet est en train de pourrir » en multipliant les « liens morts » qui sont comme les racines traversantes d’un écosystème informationnel et culturel, racines sans lesquelles il n’est pas grand chose de possible collectivement. De mon côté j’annonçais et expliquais déjà en 2010 pourquoi le « Like » allait tuer le lien (en version longue et et en version courte dans Libé).

Vertige de la vanité de tout cela y compris pour celles et ceux qui en sont les premiers hérauts, de Zuckerberg à Musk, et qui comme le démontre magistralement Tim Hwang dans Le grand krach de l’attention, ne peuvent entièrement ignorer l’effet Barnum qui est au coeur des industries de la publicité et du marketing dont l’essentiel des critères de ciblage ont soit atteint depuis déjà longtemps leur optimum prédictif comportemental, soit relèvent de l’escroquerie ou de la vaste blague et ne nourrissent plus que des marchés qui savent que l’admettre ou le reconnaître serait signer leur immédiat effondrement, et qui capitalisent donc pour l’essentiel sur des critères de performance qui relèvent de la croyance et du souci de maintien d’une rente.

Vertige donc, de se poser la question du pourquoi ? Pourquoi lancer une nouvelle gamme d’agents conversationnels dopés à l’intelligence artificielle et disposant de « personnalités » si l’on sait que le gain en termes de ciblage publicitaire sera, au mieux, marginal ? Par-delà la motivation derrière ce projet et le pur plaisir de l’expérimentation de la simple possibilité de le faire juste « parce que ça marche« , quel peut en être … le sens ?? Et que sommes-nous face à cela, nous qui assumons la part restante de cette moitié des interactions et du trafic ? « Qu’allait-t-il faire dans cette galère » et qu’allons-nous alimenter dans ces théâtres de nos vies quotidiennes connectées ?

Scroll Talk.

L’information à l’échelle de sa production et de sa diffusion relève d’une forme de physique, traversée de grandes lois. Mais à l’échelle de sa réception, l’information est toujours une sorte de chimie complexe et mouvante.

Notre rapport à l’information (et aux autres) dépend de subtils et complexes indices de légitimité et de confiance qui se déplacent au travers de notre éducation, de nos âges, de nos expériences, de nos rapport sociaux, du temps et de l’Histoire. L’une des questions essentielles que posent ces bots, qu’ils soient aussi triviaux que des outils de publication automatisés ou aussi élaborés que ceux reposant sur de larges modèles de langage et dotés non de « personnalités » (c’est bien sûr un abus de langage qui sert des fins de marketing) mais « d’intentionnalités », c’est celle de savoir comment ils reconfigurent, dans des proportions variables mais constantes, la manière dont nous percevons la légitimité et la confiance dans les contenus qui circulent en ligne et dans les autorités qui les portent. Et qu’ils sont à la fois conçus (en termes de design) et désignés comme les nouveaux leviers attentionnels capable de nous maintenir en activité.

Rien de très nouveau pourrait-on penser tant on a déjà vu de stratégies à l’oeuvre pour capter et maintenir constante notre attention et le temps que nous passons en ligne. Rien de très alarmant non plus tant il est établi qu’il n’est pas « d’effets forts » des médias et que l’abrutissement constant de certains programmes télé ou de certains défilements sociaux ne suffit heureusement pas totalement à nous décérébrer ou à nous empêcher de penser différemment de ce que l’on nous montre même si cela peut y contribuer largement en fonction de différents contextes sociologiques et de la question clé de la diversité de nos sources d’informations.

On pourrait donc considérer qu’il ne s’agit là que d’une nouvelle forme d’ergonomie conversationnelle que je propose d’appeler le « Scroll Talk » : c’est à dire la capacité de nous amener, par la conversation avec des artefacts conversationnels, à faire défiler toujours davantage de contenus choisis à notre place. Le défilement (comme au temps du « volumen », le livre en rouleau) et la parole. Soit le retour aux deux formes de transmission des connaissances les plus archaïques et les plus anciennes, mais qui sont autant d’invariants.

Mais cela ne doit surtout pas nous empêcher de questionner les formes insidieuses d’intentionnalités qui sont à l’oeuvre dans le design comme dans le dessein de ces nouvelles interfaces conversationnelles. Et d’exercer la liberté de nous y soustraire dès lors que nous les jugeons au moins aussi toxiques qu’illégitimes. Sans omettre – c’est tout le problème – de poser la question du coût social qu’implique l’exercice d’une telle liberté.

De nous interroger aussi sur ce que serons les expériences de générations prochaines qui à la différence de la nôtre ou même de celle de nos enfants, n’auront pas vécu et métabolisé ces changements dans le rapport à l’information. Je veux dire : projetons-nous dans un monde où nous ferions en gros la même chose qu’aujourd’hui (faire défiler des contenus) mais où ce défilement ne serait plus seulement le résultat d’un protocole algorithmique statistique mais reposerait sur des prescriptions conversationnelles quasi-constantes ; et où ces prescriptions conversationnelles seraient « incarnées » par des agents (bots) dotés d’intentionnalités suffisamment floues et opaques pour être assimilées ou interprétées comme autant de « personnalités » ; « personnalités » pour lesquelles on pourra sans grande difficulté nous laisser croire que nous les choisissons ou déterminons alors qu’elles nous seront attribuées et ajustées.

Comment traiterons-nous alors ces agents conversationnels personnalisés ? Le ferons-nous comme nous traitons aujourd’hui Siri, Alexa ou Ok Google ? C’est à dire essentiellement comme des télécommandes vocales ? Ou y verrons-nous autre chose ? Et cet autre chose sera-t-il susceptible de modifier substantiellement et durablement ces subtils et complexes indices de légitimité et de confiance qui façonnent notre rapport à l’information, et donc en partie notre personnalité et les modalités de nos vies communes et de nos démocraties ?

Zuckerberg et l’ensemble des thuriféraires de l’IA conversationnelle répondent par l’affirmative à la dernière question du paragraphe précédent. D’où l’obligation qui nous est faite de proposer d’autres réponses, d’autres scénarios, d’autres interrogations. Une intention n’est pas une personne. Une intentionnalité ou une somme d’intentionnalités ne fait pas une personnalité.

Du Web sémantique au Web synthétique.

Août 2023. Le Financial Times prête à Zuckerberg les propos suivants :

« M. Zuckerberg a déclaré qu’il envisageait des « agents d’IA qui agissent comme des assistants, des coachs ou qui peuvent vous aider à interagir avec des entreprises et des créateurs », ajoutant : « Nous ne pensons pas qu’il y aura une seule IA avec laquelle les gens interagiront.«

Septembre 2023. Bru, Billie, Lorena, Max et quelques autres figurent parmi ces premières IA « avec personnalité » lancées par Méta.

Mai 2001. Tim Berners Lee, James Hendler et Ora Lassila publient l’article fondateur qui pose les bases du Web sémantique, article entièrement (et finement) traduit à l’époque par Jo Link-Pezet (ma directrice de thèse) et Elisabeth Lacombe. Il est aussi passionnant que sidérant de relire aujourd’hui cet article et de mesurer à quel point il était tout à fait visionnaire y compris sur des enjeux actuels des grands modèles de langage et de l’IA et constitue une précieuse grille de lecture rétrospective. A fortiori si vous avez, comme moi, traversé ces deux époques 😉

Toute l’ambition d’un Zuckerberg (et d’autres) de créer des « agents » qui soient comme des assistants ou des coachs et nous aident à interagir avec des contenus était déjà présente, décrite, et en partie opératoire dans le texte publié 22 ans plus tôt par Berners-Lee, Hendler et Lassila. Mais ce sont deux autres passages du texte de 2001 que je veux souligner ici.

Voici le premier :

L’information varie selon de nombreux axes. L’un de ceux-ci est la différence entre l’information produite principalement pour la consommation humaine et celle produite essentiellement pour des machines. A un bout de l’échelle, nous trouvons de tout : des publicités pour la télévision commerciale qui durent cinq secondes à de la poésie. A l’autre bout, nous avons des bases de données, des programmes et des indicateurs. A ce jour, le Web s’est développé plus rapidement comme médium de documents destinés à des gens plutôt qu’en tant que données et information pouvant être traitées de manière automatique.

La question que posent les bots déjà existants et les futurs à naître et dotés d’intentionnalités calculées bien plus que de personnalités, est la même que celle qui préoccupait Tim Berners-Lee et ses collègues à l’époque, mais à l’envers. Il s’agissait de permettre à des machines (des « agents ») de pouvoir automatiser le traitement de certaines informations (notamment grâce au langage XML et RDF) et de faire en sorte que les contenus du web (les « données » et « informations ») deviennent « lisibles » pour des agents logiciels et puissent dès lors servir de base à l’établissement de différents services (de réservation, de navigation, etc.).

Or s’il fallait aujourd’hui reprendre ce texte de 2001, nous nous trouvons dans une situation inverse ou en tout cas sur le point de basculer à l’inverse : à un point où l’information produite essentiellement (par et) pour des machines peut l’emporter sur l’information produite pour la consommation humaine. C’est le principe même de ces artefacts génératifs entraînés au Deep Learning (comme ChatGPT) mais aussi de la massification des écosystèmes de bots à des fins de saturation des différents espaces interactionnels et conversationnels en ligne, soit pour répondre à des stratégies purement commerciales et transactionnelles, soit pour y déployer des stratégies d’influence (légitimes ou non). Et cela change tout. Puisqu’au lieu d’envisager une technologie (le web sémantique à l’époque) comme une possibilité de services à l’échelle de l’humanité, on envisage une humanité comme banc de test de technologies dont les rares services produits pour quelques-uns sont la part visible d’une exploitation délétère de nos économies libidinales et d’une mise au supplice de toute une autre part de l’humanité (Digital Labor).

L’autre point que je veux mettre en lumière dans le texte qui pose les bases du web sémantique en 2001 concerne un sujet que je chronique depuis toujours sur ce blog et qui devrait être l’une de nos premières préoccupations communes à l’échelle des technologies numériques actuelles : celui des heuristiques de preuve, c’est à dire la manière d’attester collectivement de la véracité d’un fait ou d’une information. Non pas pour combattre ou interdire la production de faux et de fakes (il y en a toujours eu dans toute l’histoire des productions humaines) mais pour en documenter les logiques de production à l’échelle des risques qu’ils font courir dans le champ social, économique, culturel et politique.

Voici donc ce que Tim Berners-Lee, Ora Lassila et James Hendler écrivent dès qu’ils abordent la question des « agents » que l’on qualifierait aujourd’hui de « bots ».

Les agents. Le pouvoir véritable du Web sémantique sera atteint quand les gens créeront de nombreux programmes qui collecteront les contenus du Web à partir de sources diverses, qui traiteront l’information et échangeront les résultats avec d’autres programmes. L’efficacité de ces agents logiciels croîtra de manière exponentielle au fur et à mesure que seront disponibles des contenus du Web lisibles par des machines et des services automatisés (comprenant d’autres agents). Le Web sémantique promeut cette synergie : même les agents qui ne sont pas expressément fabriqués pour travailler ensemble peuvent transférer des données entre eux si les données sont accompagnées de sémantique.

Jusqu’ici c’est une vision tout à fait exacte de ce que nous vivons aujourd’hui … avec 20 ans d’avance. Et de poursuivre :

Un aspect important du fonctionnement des agents sera l’échange de « preuves » écrites dans le langage unifié du Web sémantique (langage qui exprime les inférences logiques en utilisant des règles et des informations comme celles qui sont spécifiées par les ontologies). Par exemple, supposons que l’information pour contacter Madame Cook ait été localisée par un service en ligne, et à votre grande surprise il la situe à Johannesburg. Vous voulez naturellement vérifier cela, donc votre ordinateur demande au service de prouver sa réponse, ce qu’il fait rapidement en traduisant son raisonnement interne en langage unifié du Web sémantique. Un moteur d’inférence dans votre ordinateur vérifie que la Madame Cook en question est bien celle que vous cherchiez, et il peut vous montrer les pages Web pertinentes si vous avez encore des doutes. Bien qu’ils soient encore loin d’atteindre les profondeurs du potentiel du Web sémantique, quelques programmes sont déjà capables d’échanger des preuves de cette façon, en utilisant les premières versions courantes du langage unifié.

« Échanger des preuves« . À des fins de certification documentaire autant que de réassurance personnelle et sociale. Où est aujourd’hui la question des « preuves » quand on évoque les technologies dites « d’intelligence artificielle » ? On l’avait vue évoquée lors de la hype d’il y a quelques mois autour des générateurs d’image avec pour presque seul horizon le voeu de l’ajout d’un filigrane mentionnant « image générée par telle ou telle IA« , ce qui témoigne de la même ambition que celle visant à lutter contre le dérèglement climatique par la suppression de l’impression des tickets de caisse. On dispose, bien sûr, de tout un ensemble de dispositifs technologiques permettant de travailler la question de la certification, notamment dans le domaine bancaire et commercial (cryptographie, blockchain, etc.). Mais la question fondamentale des heuristiques de preuve est celle du tiers de confiance. Et notamment au sein des plateformes de médias sociaux, elle est très loin d’être réglée puisque ces mêmes plateformes refusent de la poser autrement qu’à l’aune de l’une des pierres angulaires du web qui consiste à opposer les éditeurs et les hébergeurs. Or cette question de la « confiance » permettant de bâtir des « preuves » traverse aussi bien les questions techniques du simple hébergement que celles, déontologiques, de la responsabilité éditoriale.

Au rêve du web sémantique, s’est substitué celui d’un web synthétique. Dans ce web « synthétique », ou plus exactement entre les murs de ces plateformes sociales synthétiques, ce sont essentiellement des machines et des programmes qui sont à l’oeuvre. C’est faire le choix, pour planter un clou, de mobiliser l’énergie d’une bombe atomique plutôt que celle d’un marteau.

One More Thing.

Finir avec Deleuze.

On fait parfois comme si les gens ne pouvaient pas s’exprimer. Mais, en fait, ils n’arrêtent pas de s’exprimer. (…) et nous sommes transpercés de paroles inutiles, de quantités démentes de paroles et d’images. La bêtise n’est jamais muette ni aveugle. Si bien que le problème n’est plus de faire que les gens s’expriment, mais de leur ménager des vacuoles de solitude et de silence à partir desquelles ils auraient enfin quelque chose à dire. Les forces de répression n’empêchent pas les gens de s’exprimer, elles les forcent au contraire à s’exprimer. Douceur de n’avoir rien à dire, droit de n’avoir rien à dire, puisque c’est la condition pour que se forme quelque chose de rare ou de raréfié qui mériterait un peu d’être dit. Ce dont on crève actuellement, ce n’est pas du brouillage, c’est des propositions qui n’ont aucun intérêt. Or ce qu’on appelle le sens d’une proposition, c’est l’intérêt qu’elle présente. Il n’y a pas d’autre définition du sens, et ça ne fait qu’un avec la nouveauté d’une proposition. On peut écouter des gens pendant des heures : aucun intérêt… C’est pour ça que c’est tellement difficile de discuter, c’est pour ça qu’il n’y a pas lieu de discuter, jamais. On ne va pas dire à quelqu’un : « Ça n’a aucun intérêt, ce que tu dis ! » On peut lui dire : « C’est faux. » Mais ce n’est jamais faux, ce que dit quelqu’un, c’est pas que ce soit faux, c’est que c’est bête ou que ça n’a aucune importance. C’est que ça a été mille fois dit. Les notions d’importance, de nécessité, d’intérêt sont mille fois plus déterminantes que la notion de vérité. Pas du tout parce qu’elles la remplacent, mais parce qu’elles mesurent la vérité de ce que je dis. Même en mathématiques : Poincaré disait que beaucoup de théories mathématiques n’ont aucune importance, aucun intérêt. Il ne disait pas qu’elles étaient fausses, c’était pire. »

Gilles Deleuze, Pourparlers, « Les intercesseurs », « Le couple déborde », Paris, Editions de Minuit, 1990