Je suis en train de préparer ma prochaine conférence sur le thème des artefacts génératifs, dans un format « apéro-chercheur ». Et la préparant je voulais partager ici quelques réflexions que je n’aurai peut-être pas le temps d’approfondir la semaine prochaine.

Intelligence artificielle. « Artificial Intelligence » en anglais. « Arty fit sienne une telle engeance » en … phonétique approximative (selon le procédé d’homophonie et d’à peu près notamment cher à l’Oulipo et aux surréalistes avant eux). Notre rapport aux technologies est souvent du même ordre que le rapport qu’entretient la phrase « Arty fit sienne une telle engeance » avec le groupe nominal « Artificial Intelligence » : nous évoluons dans une compréhension en clair-obscur de la plupart de ces technologies. Un rapport qui artificialise l’intelligence que nous pouvons en avoir comme celle que nous leur prêtons au regard de leurs effets sociaux mais plus rarement de leurs causes « mécaniques ».

Dans la longue liste de ce qui définit une technologie, il y a d’abord le nom que l’on choisit de lui donner ou dont elle hérite par concours de circonstance, circonstances d’ailleurs pas toujours atténuantes. Comme tout ce que le choix d’un prénom ou l’héritage d’un nom peut comporter de projections, de cadres, d’envies d’identification et de marquage social, le nom attribué aux technologies dit également beaucoup de ce qu’elle tentent de projeter comme de ce qu’elles ont pour objet de masquer ou de travestir.

Voilà pourquoi s’il faut nommer et dénommer les gens, les choses et les technologies, il faut aussi interroger les processus de pouvoir de ces dénominations. Et il faut se souvenir et se méfier de la toute puissance d’un marketing technologique selon lequel il y a plus de 20 ans que nous devrions toutes et tous avoir des frigos qui parlent, plus de 10 ans que nous devrions circuler en voitures volantes autonomes, et où Elon Musk peut annoncer sans rire des colonies martiennes pour 2030 tout comme Mark Zuckerberg nous promettait avec le plus grand sérieux que nous serions aujourd’hui des milliards dans le Métavers.

« Less Is More. »

And always more is often pure bullshit.

Il y a presque 4 ans de cela, à propos des différents projets de casques ou lunettes de réalité augmentée, j’écrivais qu’il fallait être attentif à « un ensemble de technologies qui postulent qu’il faut commencer par s’isoler pour pouvoir être ensemble ; qu’il faut commencer par se dissimuler aux autres pour pouvoir communiquer avec d’autres ; qu’il faut commencer par accepter de diminuer et d’entraver nos sens pour pouvoir les voir ensuite ‘augmentés’. »

Être humain augmenté ? De manière générale, et comme l’écrivait Laurence Allard (dans un entretien au magazine Culture Mobile aujourd’hui indisponible), « les technologies de l’Homme augmenté naissent d’abord pour répondre aux besoin de l’Homme diminué. » De fait et bien souvent, initialement les prothèses de l’être humain « augmenté » sont d’abord là pour répondre à une « diminution » liée à un handicap, un empêchement, une entrave accidentelle ou génétique.

Réalité augmentée ? A bien réfléchir sur ce que l’on nomme « réalité augmentée » on constate qu’elle est d’abord une réalité diminuée parce qu’une une réalité sans réel.

Intelligence artificielle ? L’intelligence artificielle est d’abord une bêtise absolue d’artefacts (programmes et algorithmes). Se souvenir ici de ce qu’explique depuis longtemps Gérard Berry : « Fondamentalement, l’ordinateur et l’homme sont les deux opposés les plus intégraux qui existent. L’homme est lent, peu rigoureux et très intuitif. L’ordinateur est super rapide, très rigoureux et complètement con. »

Assistants intelligents ? Les « assistants intelligents » (de Siri à Alexa jusqu’à ChatGPT et au-delà) sont d’abord des idiots utiles, le révélateur de nos désistements. Ils ne nous assistent pas intelligemment, ils dirigent bêtement nos indécisions ou nos manques de temps, d’énergie ou d’envie. Et ils le font avec – entre autres – un énorme problème de biais de disponibilité et de biais de conformité, puisqu’ils n’explorent que des possibles immédiatement (et souvent commercialement) disponibles et, pour l’essentiel, qu’ils nous renvoient et nous « assistent » vers du même, vers de l’identique, vers de la reproduction linéaire de comportements déjà immensément prévisibles. Ils sont donc parfaitement étrangers à toute forme d’intelligence.

Langage naturel ? Le langage naturel est souvent convoqué pour décrire notre capacité à interroger différents artefacts génératifs ainsi que leur propre capacité à nous répondre « en langage naturel ». Or ce que nous dénommons « langage naturel » est d’abord et avant tout un dialogue artificiel. ChatGPT (et les autres) ne nous répondent pas en langage « naturel » car il n’est rien de moins naturel que les échanges dialogués que nous avons avec ces artefacts. Pour s’en convaincre il suffit de regarder l’immensité des procédures et opérations techniques qui permettent cette illusion de naturalité, et parmi elles notamment le processus dit de « Alignment Tuning » ainsi décrit par Zhao, Wayne Xin, et al. dans leur étude de référence parue le 31 mars 2023 : « A Survey of Large Language Models« .

Étant donné que les LLM (Large Language Models) sont formés pour capturer les caractéristiques des données des corpus de pré-entraînés (comprenant à la fois des données de haute et de basse qualité), ils sont susceptibles de générer un contenu toxique, biaisé ou même nuisible pour les humains. Il est nécessaire d’aligner les LLM sur les valeurs humaines, c’est-à-dire qu’ils soient utiles, honnêtes et inoffensifs (sic). À cette fin, InstructGPT conçoit une approche de réglage fin (« fine-tuning ») qui permet aux LLM de suivre les instructions attendues, qui utilise la technique d’apprentissage par renforcement avec un retour d’information humain. Il incorpore l’humain dans la boucle de formation avec des stratégies d’étiquetage élaborées. ChatGPT est en effet développé sur une technique similaire à InstructGPT, qui montre une forte capacité d’alignement en produisant des réponses de haute qualité et inoffensives, par exemple en rejetant de répondre à des questions insultantes.

Si le langage « naturel » ne peut l’être qu’à condition d’être au préalable « aligné » par des travailleurs invisibilisés (Digital Labor) sur des principes d’utilité, d’honnêteté (sic) et d’innocuité alors que reste-t-il à ce langage de naturel ? Imaginez un instant une société dans laquelle toute forme de langage ou d’échange conversationnel serait ainsi « supervisé » par ces 3 règles. C’est littéralement le rêve de la novlangue et du néo-parler Orwellien.

Chaque fois que revient cette question du dialogue en langage naturel, je rappelle ce que j’écrivais en 2016 sur le sujet :

Aucune question même formulée en langage naturel n’est vraiment naturelle car elle ne s’adresse pas à un individu mais à une somme d’instructions mathématiques construites selon un déterminisme algorithmique permettant de valoriser un régime médiatique de la popularité et le modèle économique qui l’accompagne.

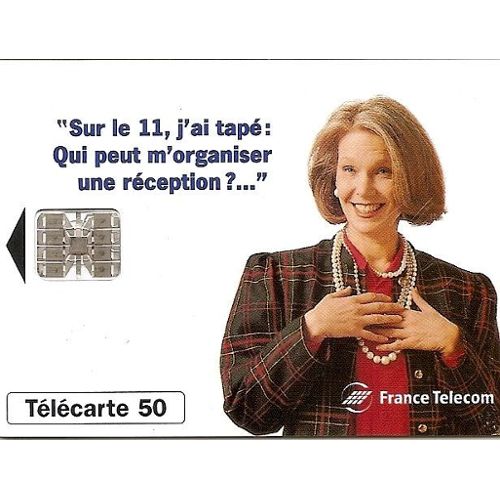

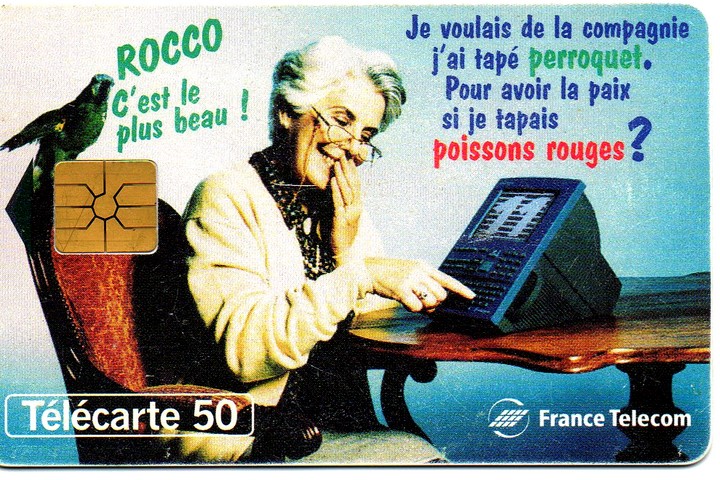

Et je me souviens aussi de ces chatoyantes cartes France Télécom du tout début des années 2000 :

Et oui. Le langage « naturel », déjà à l’orée des années 2000. Et même les perroquets stochastiques de Emily M. Bender, Angelina McMillan-Major, Shmargaret Shmitchell et Timnit Gebru étaient déjà là plus de 20 ans avant la publication de leur article 😉

Dans le cas de ChatGPT et de ses clones et sbires, la formule que j’employais à l’endroit de Google pourrait être reformulée sans y changer presque rien. Et voici ce que cela donne.

Aucune question même formulée en langage naturel n’est vraiment « naturelle » car elle ne s’adresse pas à un individu mais à une somme d’instructions mathématiques construites selon un déterminisme algorithmique permettant de valoriser un régime probabiliste de satisfaction du requêtant, optimisé et calibré par un travail humain invisibilisé.

Le régime de construction de chacune des réponses produites obéit en outre à des ontologies mouvantes et le plus souvent imperscrutables mais qui toujours reflètent une vision du monde, sauf lorsque par négligence ou par choix, elles font l’impasse de cette vision en se moquant totalement des implication sociales et politiques des réponses apportées tant qu’elles maintiennent un horizon de rente économique.

Des technologies aux technoloquies.

Nous venons d’un monde où les discours sur les techniques se sont élaborés et construits à la fois sur le plan mécanique et artefactuel comme sur le plan philosophique. Nous avons un discours (logos) sur des activités de production ou de fabrication (techné). Nous entrons depuis quelques années déjà, dans un monde où la technique nous parle et où cette capacité de parler interroge fondamentalement la capacité de sincérité de la langue, son « honnêteté » et/ou son « innocuité » comme évoqué plus haut. D’autant que nous somme souvent incapables de savoir qui parle réellement derrière ces technologies parlantes, technologies qui ne sont qu’autant de formes de ventriloquies : des technoloquies.

Sans entrer dans un long rappel historique, tout commence avec le test de Turing (1950) où il s’agit évaluer la capacité d’une machine à imiter le comportement humain, et plus précisément, sa capacité à simuler une conversation avec un être humain de manière convaincante.

Puis, avec le premier programme informatique qui simule l’interaction langagière avec un psychothérapeute reformulant la plupart des affirmations du « patient » en questions et en les lui posant, son auteur Joseph Weizenbaum pointe ce qu’il nomme l’effet Eliza (1964-1966), c’est à dire la tendance à assimiler de manière inconsciente le comportement d’un ordinateur à celui d’un être humain, très exactement « la prédisposition à attribuer à des suites de symboles générés par ordinateur (en particulier à des mots) plus de sens qu’ils n’en ont réellement. »

À l’arrivée de ChatGPT en 2022 nous savons donc :

- que les programmes informatiques sont capables d’imitation,

- que nous sur-interprétons ce que la machine répond,

- que nous prêtons à la machine des capacités qu’elle n’a pas.

Nous avons en outre appris que les algorithmes sont bourrés de biais et qu’ils automatisent et aggravent les inégalités bien plus qu’ils ne les corrigent ou les atténuent (lire notamment Safiya Umoja Noble « Algorithms Of Oppression » 2018, Cathy O’Neil « Weapons of Math Destruction », 2016 et Virginia Eubanks « Automating Inequality », 2018).

Pour le dire plus simplement :

- Nous savons qu’ils mentent.

- Nous savons que nous savons qu’ils mentent.

- Nous savons qu’ils ne savent pas qu’ils mentent puisque mentir est à la fois une opération procédurale (qui peut être programmée) mais relève aussi d’une interprétation et d’un jugement moral.

Parlons maintenant rapidement de ventriloquie. La technique de ventriloquie s’appuie sur plusieurs types de mécanismes et de stratagèmes. L’un des premiers consiste par exemple à éviter les phonèmes nécessitant un mouvement important des lèvres – par exemple le son [p] ou [m] – ou une ouverture significative de la bouche – par exemple passer du [i] au [a]. Le ventriloque peut alors soit éviter les mots avec ces sons, soit remplacer ces sons et les mots qui les contiennent par d’autres mots qui ne les contiennent pas :

Par exemple, [b] est remplacé par [v] ou [h]. Barrière devient varrière, bonjour devient honjour. [p] est remplacé par [h]. Par devient har. [n] remplace [m]. [f] devient [h]. Formidable devient hormidagle. (…). Mexique devient exique. À chaque fois, le ventriloque compte sur la capacité du cerveau de l’auditeur à corriger automatiquement (et surtout inconsciemment) les sons erronés qu’il entend. Celui-ci l’accepte d’autant mieux que les personnages inventés par les ventriloques sont des animaux. (Source : Le bout de la langue)

Beaucoup d’entre nous ont également vu passer l’expérience classique de compensation et de correction cognitive :

Une étude de l’unitiersvé de Cigbmdare a mtnoré que l’on puet snas plorèmbe lrie un txete dont les letetrs snot dnas le drrdoése puor peu que la pieèrrme et la dnèeirre lttere de cquhae mot rsnetet à la bnone pacle. Ccei mortne que le caerevu ne lit pas teouts les ltrtees mais pnerd le mot cmmoe un tuot. La pruvee : avuoez que vuos n’aevz pas eu de mal à lrie ce txtee.

« Artificial Intelligence » demanda-t-il. « Arty fit sienne une telle engeance » répondit-il.

Dans ces « technoloquies » quelle est la part de l’illusion ? Quelles sont les substitutions qui s’opèrent et que notre cerveau corrige avec un effort à peine conscient ? Et si notre cerveau « accommode » au sens optique du terme c’est à dire s’il effectue un ensemble de mises au point visant à la netteté de la perception, alors dans le cas précis de ces technoloquies, de quoi s’accommode-t-on réellement ?

Voilà pourquoi notre premier travail de chercheur mais aussi de citoyen est de prendre la sémantique technologique à revers (car elle est souvent une antiphrase) et notre responsabilité politique est d’essayer de la remettre à l’endroit.

Bonjour Olivier, très intéressant as usual. Pour la citation de Culture Mobile, dont je te remercie, voici la bonne référence : https://issuu.com/culturemobile/docs/culturemobile_visions_laurence-allard

Au plaisir !

‘LLo,

« que les programmes informatiques sont capables d’imitation,

que nous sur-interprétons ce que la machine répond,

que nous prêtons à la machine des capacités qu’elle n’a pas. »

Ne pourrait-on point pour les deux derniers items, chèr maître (des mots) ,en inventez un, le digitalomorphisme ou numéricomorphisme ?

& ainsi paraphraser un autre célèbre manieur de mots; « Mal nommer les choses, c’est ajouter au Bazar numérique du monde digital/numérique qui vient… »

Best regards 😉

& qu’aperçois-je en me relisant, deux coquilles & une partie interrogative qui n’a ni queue ni tête ?

Comme quoi, les mots sont singulièrement, sémantiquement & éthymologiquement retors des fois, pfuuu !